In un mondo perfetto, le aziende digitali testano tutto quello che rilasciano, spingendo i team a prendere decisioni consapevoli in grado di cambiare le sorti dell’azienda. Nella realtà, le aziende si impegnano per raggiungere tale obiettivo promuovendo una cultura dell’esperimento: questo significa fare test A/B di specifiche idee con un gruppo di controllo e valutarne quindi l'impatto.

Due cose positive ne derivano: le buone idee maturano e si sviluppano pienamente, mentre quelle non valide tornano al punto di partenza per essere riformulate.

Questa guida illustra come condurre test A/B efficaci per apportare modifiche costanti al sito web che gli utenti possano apprezzare.

Ma c'è di più! La nostra guida dettagliata ti mostra anche come capire quale versione conquista i cuori degli utenti e scoprire perché. Spoiler: il segreto per capire il perché è quello di usare piattaforme complementari come quella di Contentsquare (sì, siamo proprio noi!).

Hai voglia di capire come? E allora iniziamo!

Come eseguire i test A/B nel modo giusto: i 5 passaggi per il successo

Il test A/B, talvolta chiamato anche split testing, è la soluzione ideale per aiutare i team a trovare la direzione in cui muoversi. E questo sia per chi si occupa di sviluppo, user experience (UX), prodotto, marketing o design. Anche se impostarne uno è relativamente semplice, un test A/B d’impatto richiede più di quanto si possa pensare.

Combinare i risultati dei test con le riproduzioni, le heatmap e gli strumenti di feedback, aiuta come mai prima a valutare le performance, formulare nuove idee e promuovere l'innovazione guidata dagli utenti. Questo riduce inoltre il tempo necessario per condurre test che portino a risultati concreti e utili, ma ne riparleremo più avanti.

Per prima cosa, vediamo come eseguire i test A/B correttamente con 5 semplici passaggi.

Fase 1: formulare un'ipotesi basata su prove concrete

Tutto inizia con un'idea. Ad esempio:

Una piattaforma di streaming che vuole migliorare il sistema di personalizzazione per facilitare agli utenti la scoperta di nuovi contenuti, con l’intento di incrementare la soddisfazione del cliente e la fidelizzazione.

Un E-commerce desidera ottimizzare il processo di registrazione per i nuovi utenti, con la possibilità di un incremento delle vendite.

Un test A/B non può però basarsi solo su ipotesi. Richiede una ricerca informale, che esamini i dati disponibili per trovare idee da testare. In genere i team formulano un'ipotesi a partire da dati quantitativi e qualitativi, come ad esempio l'elenco delle migliori pagine di uscita combinato con le risposte a un sondaggio sull'exit-intent.

🧪 Quali sono le caratteristiche di una buona ipotesi?

Una buona ipotesi è un'affermazione fondata su prove e testabile che:

Offre una soluzione a un problema o ne spiega i motivi.

Prevede un esito per l'esperimento.

Illustra il ragionamento che porta alla previsione del risultato atteso.

Ecco un esempio di ipotesi che prendiamo da Netflix: "se effettuiamo il cambiamento X, miglioremo l'esperienza degli utenti in modo tale da far aumentare la metrica Y."

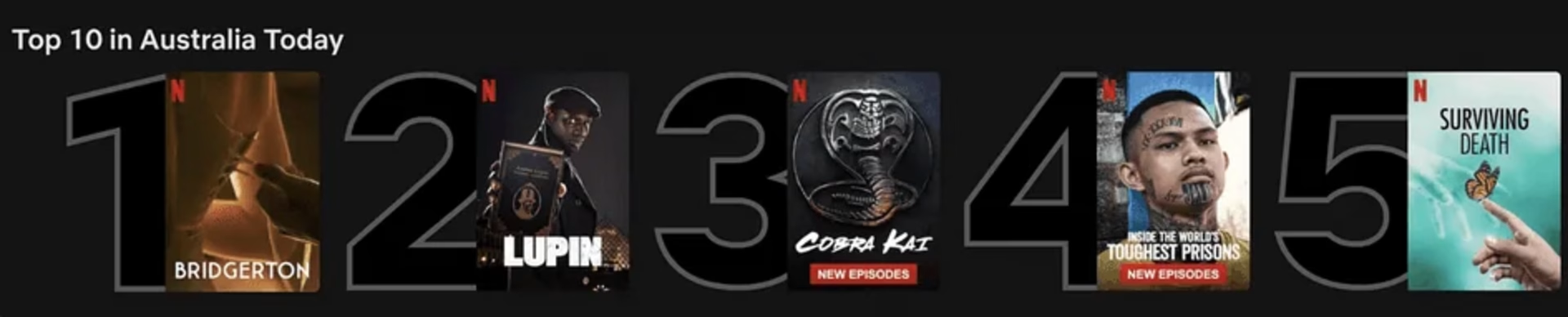

Quando i maghi dell'esperienza utente (UX) di Netflix hanno pianificato i test delle liste "top 10" che vediamo sull’interfaccia utente (UI) web, l’ipotesi era: "mostrare agli utenti le 10 migliori opzioni li aiuta a trovare qualcosa da guardare, aumentando felicità e soddisfazione.

La top 10 di Netflix

Fase 2: selezionare lo strumento per il test A/B

A questo punto è arrivato il momento di trovare uno strumento per i test A/B che sia adatto a condurre l'esperimento. Ecco una breve panoramica di alcune delle migliori alternative:

I 3 strumenti più gettonati per l'A/B testing e la sperimentazione dei prodotti

1. Optimizely

Optimizely è una piattaforma di sperimentazione leader nel settore, che permette anche a chi non si occupa di sviluppo di eseguire test A/B e multivariati sui siti web. La sua interfaccia intuitiva e la UX user-friendly soddisfano una vasta gamma di utenti, inclusi designer e marketer.

👍 Vantaggi:

Rende semplice la creazione di report efficaci.

Attiva sondaggi per le varianti di test.

Aiuta nell'ottimizzazione del tasso di conversione (CRO).

Fa parte del Partner Ecosystem di Contentsquare.

👎 Svantaggi:

Una delle alternative più costose.

2. AB Tasty

AB Tasty è una piattaforma multifunzione per l’ottimizzazione del tasso di conversione (CRO) che offre test A/B, personalizzazione, user engagement e segmentazione del pubblico. Puoi facilmente combinare opzioni per il targeting, come la geolocalizzazione e il comportamento degli utenti, per creare esperimenti personalizzati per il tuo pubblico ideale.

👍 Vantaggi:

Sperimentazione senza limiti.

Semplice da usare anche per i team con poca competenza tecnica.

Fa parte del Partner Ecosystem Contentsquare.

👎 Svantaggi:

Poche funzionalità avanzate per la sperimentazione.

Tempi di caricamento della pagina più lenti.

3. Contentsquare

Contentsquare (rieccoci!) è una piattaforma multifunzione di experience intelligence che i team possono usare per monitorare la digital experience del sito. L'integrazione di Contentsquare con uno strumento per i test A/B completa i risultati e aiuta a individuare le vere opportunità di miglioramento.

Anziché elencare i pro e i contro di Contentsquare, lasciamo parlare i nostri utenti reali: 👉 leggi le recensioni.

Nota: il secondo e il terzo passaggio possono essere invertiti. È possibile infatti definire i dettagli specifici del test prima di scegliere uno strumento che abbia tutte le funzionalità necessarie per eseguirlo efficacemente.

Fase 3: impostare l'esperimento

Ricorda che è l'ipotesi a chiarire cosa si vuole cambiare e qual è la metrica principale da misurare. Una volta definita l'ipotesi, è il momento di:

Creare due versioni di... qualcosa. Qualsiasi cosa: l’oggetto di una email, un pulsante CTA o il layout di una landing page. La versione A di riferimento (o "versione di controllo") mostra l’elemento, il progetto o la pagina attuale. Contemporaneamente, la variante B implementa la modifica o l'insieme di modifiche da analizzare. Entrambe le versioni devono essere identiche in qualunque altro aspetto.

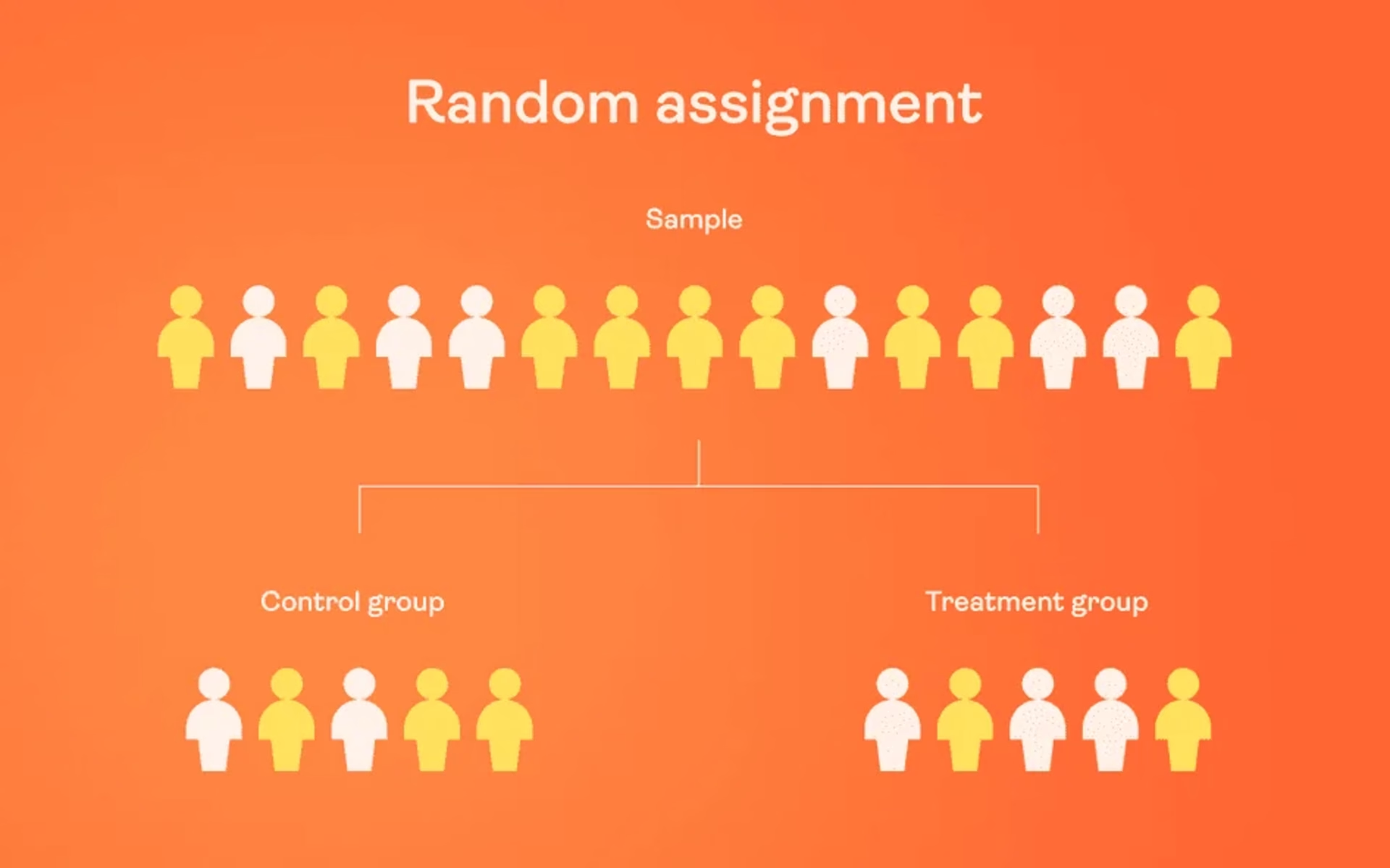

Selezionare un sottoinsieme di utenti da usare come campione. Successivamente, il campione va suddiviso in due gruppi uguale assegnandoli all'uno o all'altro in maniera aleatoria. Un gruppo vedrà la versione di controllo, mentre l'altro la variante.

Funzionamento dell'assegnazione casuale nei test A/B per prodotti o siti

Decidere quale deve essere il livello di confidenza. L'intervallo di confidenza determina il grado di certezza dei risultati. Nelle ricerche di mercato si usa solitamente un livello di confidenza del 95%. Questo vuol dire che se si esegue l'esperimento 20 volte, si dovrebbero ottenere gli stessi risultati circa 19 volte (con un margine di errore).

Stabilire la dimensione del campione e il periodo di tempo dedicato agli split test. A seconda del tool usato per i test A/B, è possibile impostare la dimensione del campione e la durata del test. Se ti serve aiuto durante la selezione e non disponi di colleghi esperti in analisi a cui rivolgerti, puoi provare questo calcolatore della dimensione del campione.

Configurare ed eseguire l'esperimento usando lo strumento di test A/B selezionato. Per la stessa campagna di marketing, esegui uno dopo l'altro i test A/B delle landing page, dei CTA, degli header e delle altre variabili, per assicurarti che la catena causale sia attribuibile a una specifica modifica o a un insieme di modifiche, invece che a un'altra combinazione di fattori.

Fase 4: analizzare i risultati del test A/B

Durante l’analisi dei risultati dei test nello strumento selezionato per i test A/B, è fondamentale considerare la significatività statistica. Procedere con una versione che sembra migliore solo per un errore di campionamento o per puro caso è decisamente qualcosa da evitare. Di solito, una significatività statistica del 95% indica che l'opzione è sicuramente vincente e che tutto è pronto per dare il via libera.

Se l'esito è statisticamente significativo, non ti resta che disattivare la variante non selezionata nello strumento di test A/B e procedere con la versione vincente! 🎉

E se invece nessuna delle varianti risultasse statisticamente superiore? In tal caso, il test va considerato inconcludente e si ritiene quindi che la variabile testata non ha avuto un impatto significativo sui risultati.

Ma non c'è da disperarsi, perché anche da questo si può trarre una lezione: mantenere la versione originale oppure usare i dati infruttuosi per creare una nuova iterazione per un altro test.

Ad esempio, supponiamo che il team di marketing e-commerce abbia appena concluso un test A/B per decidersi tra due diversi layout della pagina prodotto. Dopo aver raccolto dati sulla percentuale di clic, sul tasso di aggiunta al carrello e sulle vendite, ci si rende conto che risultati non fanno emergere una variante nettamente superiore.

Che si fa ora?

Si potrebbe analizzare i dati con maggiore attenzione, per verificare se esistono sottogruppi di utenti che reagiscono diversamente alle varianti. In alternativa, è possibile fare un nuovo test con una variabile differente, come ad esempio descrizioni alternative dei prodotti o una nuova strategia per i prezzi.

💡Consiglio dell'esperto: condurre test A/B può mostrare cosa gli utenti trovano piacevole e cosa non gradiscono del sito web, dei prodotti o dei servizi. Quello che però manca, è il contesto: il motivo per cui preferiscono una variante rispetto a un'altra.

Contentsquare è una piattaforma di experience intelligence che ti aiuta a colmare le lacune e a capire meglio il comportamento e le preferenze degli utenti. Grazie alle integrazioni e alle collaborazioni tecnologiche, puoi visualizzare le riproduzioni, analizzare le heatmap o attivare sondaggi per gli esperimenti usando Optimizely e AB Tasty.

In questo modo hai l'opportunità di raccogliere insights qualitativi, ad esempio per il nuovo design della homepage, da un gruppo selezionato di utenti prima di investire tempo, denaro e risorse per il lancio su vasta scala.

Fase 5: guardare le riproduzioni delle sessioni degli esperimenti

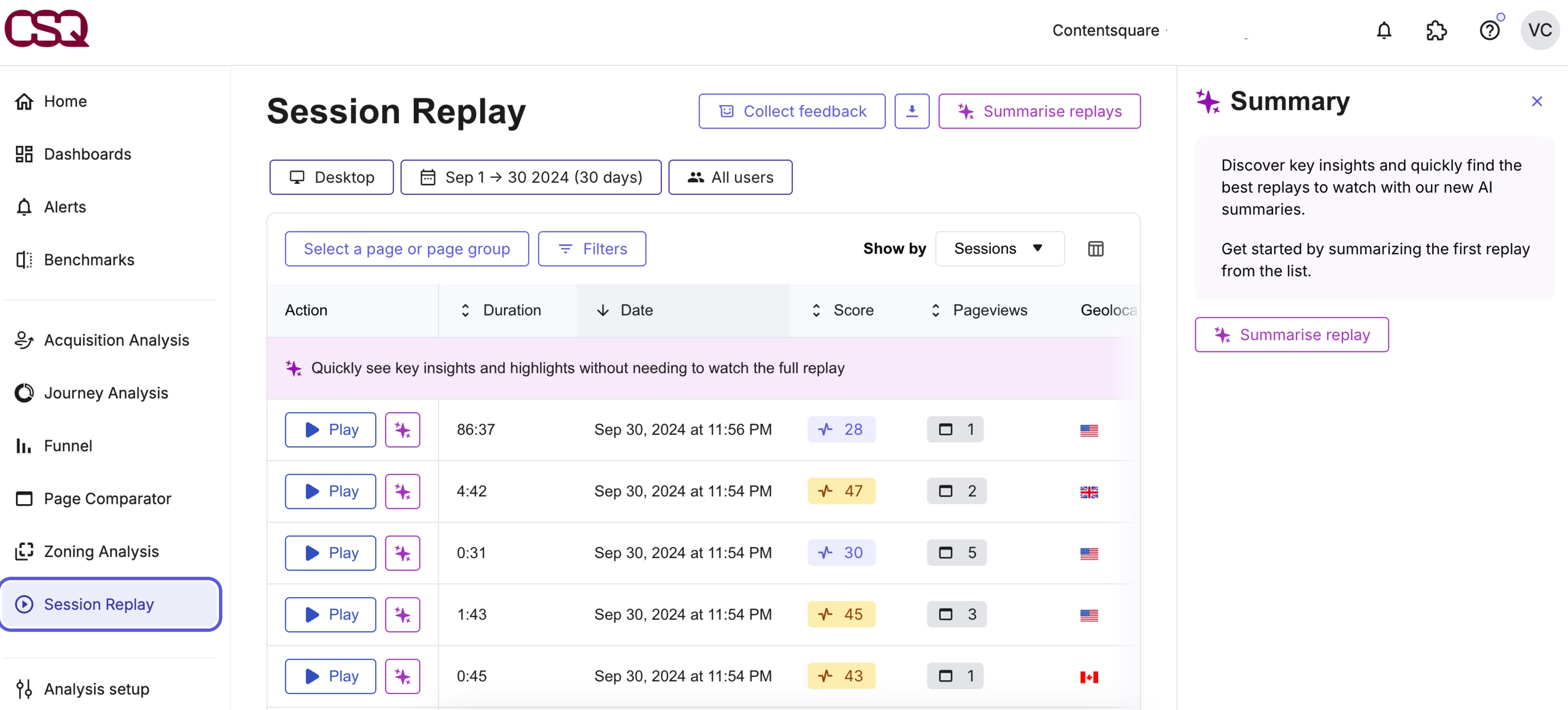

Con l'aiuto di strumenti complementari di A/B testing che offrono insights più approfonditi sulle behavior analytics, è possibile esaminare le riproduzioni delle sessioni per vedere esattamente come gli utenti interagiscono con la variante dell'esperimento: come navigano, cosa cliccano e cosa ignorano.

Questo non solo ti permette di individuare la variante vincente, ma ti fa anche capire il perché.

Ecco alcuni metodi per analizzare le riproduzioni e integrare gli insights qualitativi al metodo usato per la sperimentazione dei prodotti:

Considerare l'engagement e il comportamento previsto, ma osservare anche la presenza di eventuali segnali inaspettati di attrito, come ad esempio i rage click.

Seguire il percorso del visitatore per tutta la riproduzione per capire in che modo l'elemento testato si inserisce nell'user journey e se questo facilita l'esperienza o devia l'andamento della navigazione.

💡 Consiglio dell'esperto: puoi usare il punteggio di frustrazione di Contentsquare per dare priorità alle modifiche da apportare.

Il punteggio di frustrazione classifica automaticamente le sessioni in cui gli utenti hanno incontrato delle difficoltà. In questo modo, è possibile trovare facilmente le registrazioni con aree di attrito, senza dover passare al setaccio ore di contenuti.

Contentsquare individua automaticamente i principali ostacoli che spingono gli utenti ad abbandonare il tuo sito.

Le best practice per i test A/B con Contentsquare

Come già accennato, è possibile configurare Contentsquare al di fuori delle integrazioni, per aiutare a monitorare i test A/B e aggiungere profondità all'A/B testing grazie aidati quantitativi e qualitativiche questi strumenti forniscono. Una volta finito, saprai esattamente cosa fare (e cosa evitare), evitando così di sprecare risorse preziose per modifiche che si rivelerebbero inefficaci.

Mostrare un widget di feedback su una variante

Raccogli i feedback degli utenti su una specifica variante della pagina. Il widget Feedback Collection di Contentsquare permette agli utenti di condividere facilmente le loro impressioni quando, durante uno degli esperimenti, incontrano un ostacolo o trovano qualcosa di loro gradimento.

Questo è il momento in cui è possibile condurre ricerche avanzate con l'ausilio di diversi strumenti per conoscere il parere dei clienti, come ad esempio i sondaggi, che consentono di raccogliere il feedback degli utenti. Sono questi, infatti, a incontrare davvero le difficoltà e sono quindi loro la chiave per risolverle.

Il widget di feedback di Contentsquare permette agli utenti di evidenziare gli elementi che apprezzano e quelli che invece trovano spiacevoli.

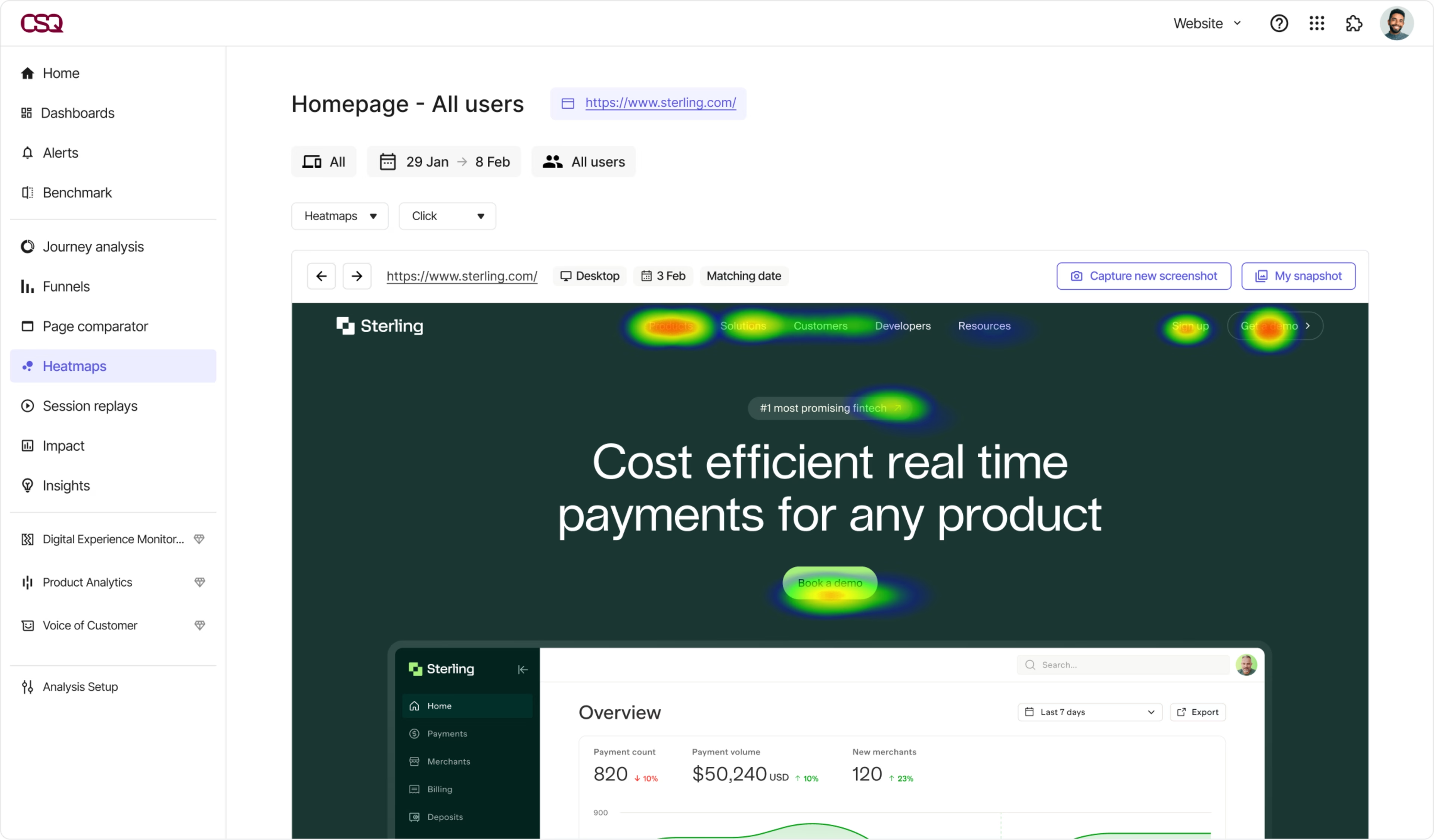

Confronto delle heatmap per la variante di controllo e quella di test

Puoi usare le heatmap per monitorare il test A/B, a seconda delle seguenti condizioni:

Varianti sullo stesso URL: significa che il test A/B è stato configurato per caricare in modo aleatorio una delle due varianti per ogni utente che visita la pagina. In questo caso, filtra le sessioni per visualizzare le heatmap corrispondenti.

Varianti su URL diversi: usa il filtro URL delle heatmap per monitorare i dati di ogni variante. Seleziona un filtro URL e inserisci l’URL di controllo e/o quello della variante, per visualizzare le heatmap corrispondenti.

Le heatmap offrono insights più pertinenti durante i test A/B

Guarda le riproduzioni delle sessioni degli utenti esposti alla variante

Le riproduzioni ti permettono di vedere con i tuoi occhi il modo in cui gli utenti si comportano quando confrontati alle diverse varianti del sito o della pagina. Session Replay di Contentsquare consente inoltre di visualizzare il comportamento degli utenti durante gli esperimenti. In questo modo, hai l'opportunità di osservare se gli utenti hanno notato le modifiche, come hanno reagito e gli eventuali problemi di usabilità riscontrati durante l'esperimento.

Per approfondire ulteriormente gli insights sugli utenti, Contentsquare permette anche di associare i feedback del sito web e le risposte ai sondaggi con le relative riproduzioni delle sessioni. Quando ricevi un feedback, puoi passare direttamente alla registrazione pertinente per vedere quali sono le azioni che il cliente ha appena compiuto.

Guardando le sessioni, puoi capire quale design ha favorito interazioni più scorrevoli e maggior engagement, fornendoti prove concrete su quale layout si è rivelato più efficace.

Scopri se i messaggi sono chiari ed efficaci o se invece confondono gli utenti

💡 Consiglio dell'esperto: Contentsquare ti fa scoprire le opportunità, Optimizely ti aiuta a testarle.

Grazie alla partnership tra Contentsquare e Optimizely, puoi creare test più efficaci, con meno sforzo e in meno tempo. Scopri il "perché" di ogni risultato, applica gli insights ottenuti alle prossime ottimizzazioni e ricomincia il ciclo di test.

Le funzionalità di Optimizely, come la latenza nulla, i tempi di caricamento ridotti e le esperienze personalizzate accelerate, permettono al tuo sito, prodotto o applicazione di funzionare senza interruzioni durante gli esperimenti, grazie all’uso combinato di cache e supporto.

Customer Journey Analysis e Zoning Analysis di Contentsquare mostrano come gli utenti navigano sul sito: quali pagine visitano, quanto tempo ci passano, fino a che punto scorrono la pagina e dove abbandonano.

Questo ti permette di individuare le aree per cui l'ottimizzazione è prioritaria, così da poter condurre esperimenti significativi da cui si ottengono risultati concreti.

Il vantaggio della tecnologia dei test A/B di Contentsquare è che la modifica di un test in corso e la sua messa in produzione sono facili e immediate.

Modifiche costanti per aumentare le conversioni

Non ti resta che cominciare. Inizia a eseguire test A/B anche sulle più piccole modifiche prima del lancio per il resto degli utenti. Combina i dati ottenuti da diverse fonti, ad esempio le heatmap, le riproduzioni delle sessioni e i sondaggi agli utenti, per trovare anche le opportunità che non emergerebbero guardando solo ai risultati dei test.

Evita tutte quelle modifiche che potrebbero compromettere il tasso di conversione o l'user engagement, oltre a far sprecare all'azienda risorse preziose. Con Contentsquare non ti serve nient'altro per perfezionare i tuoi esperimenti.

Domande frequenti sui test A/B

Il test A/B è una metodologia di sperimentazione che confronta due versioni di un'applicazione o di una pagina web per stabilire in quale si osservano performance migliori. I vari gruppi di utenti visualizzano la versione A o la versione B e la scelta si fa in maniera aleatoria. Le interazioni vengono quindi esaminate e confrontate per identificare quale porta ai risultati desiderati.

![[Visual] Contentsquare's Content Team](http://images.ctfassets.net/gwbpo1m641r7/3IVEUbRzFIoC9mf5EJ2qHY/f25ccd2131dfd63f5c63b5b92cc4ba20/Copy_of_Copy_of_BLOG-icp-8117438.jpeg?w=1920&q=100&fit=fill&fm=avif)