Il test A/B è una strategia ben consolidata per sperimentare diverse soluzioni e ottimizzare il sito web dell'azienda, per spingere più efficacemente gli utenti a compiere quelle azioni che incrementano le conversioni.

Se i risultati del test A/B sono positivi, questo è un segno inconfutabile che le modifiche che hai mente possono invogliare più utenti a fare affari con l'azienda. A prescindere da se vuoi testare i video di un prodotto sul tuo sito di e-commerce o un nuovo banner per registrarsi su una rivista online.

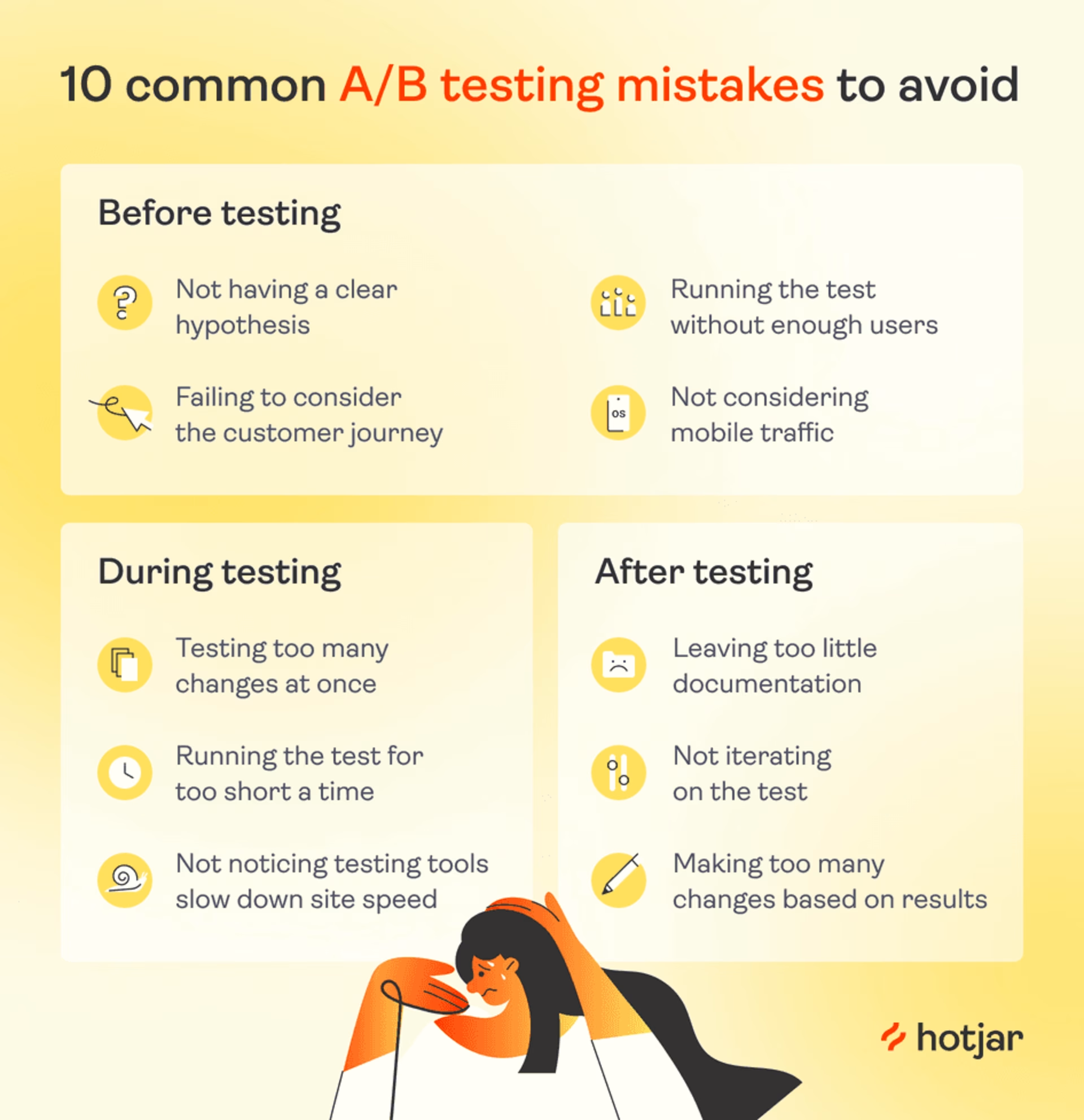

Commettere gli errori più comuni nei test A/B si traduce spesso in dati inaffidabili, il cui risultato è di deviare la strategia aziendale nella direzione sbagliata.

Ecco i dieci errori da evitare se vuoi svolgere test A/B in grado di produrre dati impeccabili e che ti aiutino a prendere decisioni consapevoli sul prodotto.

Si possono suddividere in tre categorie:

Errori in fase di preparazione

Con un test A/B, detto anche split test, si mostrano agli utenti in maniera aleatoria due versioni di una pagina web. Una rappresenta la versione standard (di controllo), mentre l'altra è la nuova versione (variante) della pagina che dovrebbe spingere più utenti a compiere un'azione desiderata.

Un test A/B che sia efficace e privo di errori deve il suo successo anche alla fase di pianificazione, se l'ipotesi e le condizioni del test sono state valutate con attenzione. Ecco alcune errori comuni che i team fanno durante l'A/B testing prima ancora di aver cominciato e come evitarli:

1. Non disporre di un'ipotesi chiara

Non è strano voler avviare un esperimento se si ha l’impressione che ci sia una certa modifica che potrebbe risultare utile. Tuttavia, un test A/B può rispondere solo a una domanda a risposta chiusa, quindi è importante formulare l'ipotesi il più chiaramente possibile.

Se decidi di eseguire un test senza avere un'ipotesi chiara, potresti lasciarti distrarre da KPI che sembrano interessanti, ma sono in realtà irrilevanti. Ad esempio, potresti finire per concentrarti sul fatto che gli utenti hanno passato più tempo sulla pagina invece che sulla metrica che ti interessa davvero.

Come risolvere il problema: per ottenere risultati utili dagli split test, è necessario specificare quale metrica si vorrebbe migliorare e perché la modifica proposta potrebbe migliorare la situazione. Questa considerazione si definisce "ipotesi di lavoro".

L'ipotesi deve essere formulata con un'implicazione logica, cioè con una frase "Se..., allora..." Ad esempio: "ritengo che se [il pulsante "Aggiungi al carrello" fosse più evidente], allora [ci sarebbe un aumento delle conversioni].

Quando si formula un'ipotesi, ci sono tre passaggi da seguire:

Fase 1. Esamina con attenzione idati delle web analytics per osservare cosa fanno gli utenti durante il percorso che li porta alla conversione. Ad esempio: "il 95% dei nostri clienti che iniziano la procedura d'acquisto, abbandonano prima di inserire i dati della carta".

💡 Consiglio dell'esperto: le piattaforme di experience intelligence come Contentsquare forniscono preziosi dettagli aggiuntivi.

Consulta la dashboard di Product Analytics per verificare le metriche più importanti, come la frequenza di rimbalzo, la durata media della sessione e le pagine con più visite. Scopri i motivi che giustificano i valori delle metriche guardando le riproduzioni o visualizzando le heatmap delle pagine che vorresti ottimizzare.

Fase 2. Formula un'ipotesi su cosa impedisce agli utenti di convertirsi, scegliendo quella che sembra meglio giustificare le informazioni già disponibili.

"Ho l'impressione che gli utenti non si convertano, perché non si fidano a inserire i propri dati sul nostro sito, che è troppo antiquato".

Fase 3. Formula un'ipotesi su una modifica che potrebbe promuovere la conversione degli utenti. Dovrebbe essere una frase che definisce chiaramente cosa si vuole ottenere con il test A/B. Puoi usare l'implicazione logica, ovvero il formato "se..., allora...".

«Suppongo che se aggiungiamo un'icona con la scritta "pagamento sicuro" sulla pagina in cui si finalizza l'acquisto, allora aumenterà il numero di utenti che si convertono».

Esamina il comportamento dei clienti → formula un'ipotesi solida → incrementa l'adozione

Session Replay consente di osservare dove i clienti cliccano e dove muovono il cursore del mouse, in modo da capire il motivo per cui non compiono le azioni desiderate.

Nel caso di Bannersnack, un'azienda che offre un tool per la creazione di banner, questa funzionalità ha permesso di ottenere riscontri pratici in merito a diverse ipotesi formulate.

Ad esempio, dopo aver lanciato la funzionalità per una visualizzazione cronologica del prodotto, i dati delle web analytics hanno segnalato al team di Bannersnack che solo alcuni tra i clienti di lunga data stavano testando la nuova funzionalità.

Dopo aver esaminato il comportamento degli utenti, guardando qualche riproduzione delle sessioni, il team si è accorto che gli utenti ignoravano completamente il pulsante "Mostra timeline", che era molto meno visibile di quanto i designer avessero immaginato.

La loro ipotesi? Se ingrandiamo il pulsante "Mostra timeline", più utenti saranno invogliati a usarlo.

Il team di Bannersnack ha quindi eseguito un test A/B per verificare se l'ipotesi fosse corretta. È bastata questa modifica a basso costo ad aumentare l'adozione della funzionalità del 12%.

![[Visual] Session Replay - What is CSQ?](http://images.ctfassets.net/gwbpo1m641r7/3XsaMYdpHjNeBE8x4r219k/eb9e7ae1ae4a0f3c0eedb754b9d23853/Session_Replay.png?w=3840&q=100&fit=fill&fm=avif)

Session Replay ti permette di capire come gli utenti reali navigano sul sito

2. Non prestare attenzione al customer journey

Assicurati che gli elementi per cui vuoi eseguire un test A/B abbiano davvero un impatto positivo sulle metriche:

Testa le pagine importanti, come quelle di prodotto, di pagamento e di registrazione, che ricevono molto traffico e fanno parte integrante del funnel di vendita.

Non eseguire test A/B su pagine poco rilevanti e che non ricevono molto traffico, come ad esempio la pagina "Chi siamo", altrimenti i risultati ottenuti non potranno mai portare a modifiche d'impatto.

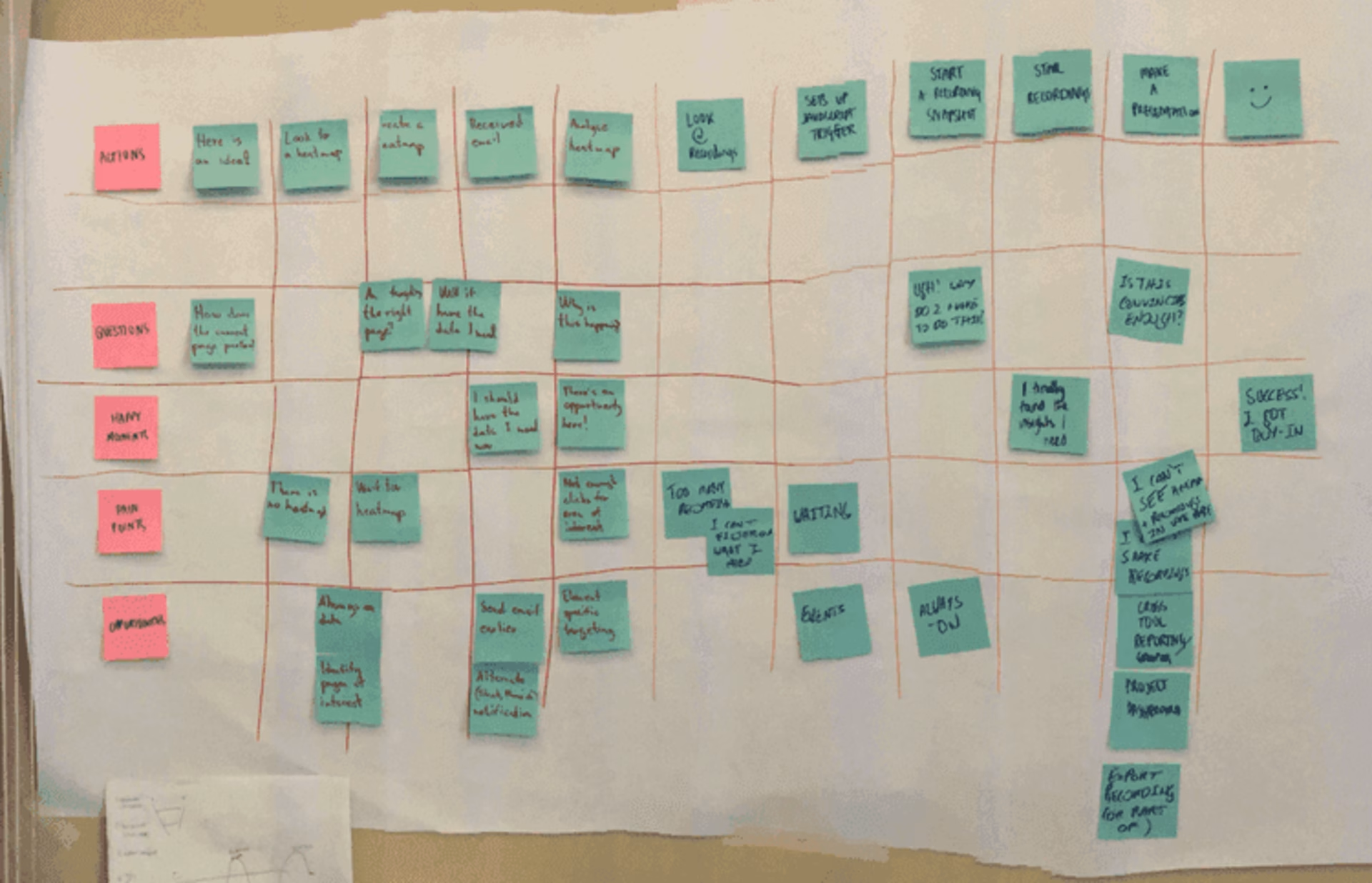

Un modo per assicurarti di aver selezionato una pagina rilevante è esaminare la mappa del percorso del cliente e cioè quei passaggi che spingono un cliente a interagire con l'azienda. Ad esempio gli utenti che:

Cliccano su un annuncio.

Consultano una pagina di prodotto.

Leggono le informazioni sulla spedizione.

In questo modo si evita di dedicare troppo tempo all'ottimizzazione di una pagina che i clienti vedono solo quando hanno già preso una decisione di conversione oppure quando non sono ancora pronti.

Una mappa del percorso del cliente (con un fascino d'altri tempi)

Come risolvere il problema: formula ipotesi tenendo presente la mappa del percorso del cliente. A prescindere dal tipo di pagina che vuoi sottoporre a un test A/B, ecco le domanda da porsi:

Quali sono le decisioni che l'utente ha già preso a questo punto?

C'è la possibilità che non abbia ancora cominciato il percorso per la conversione?

💡 Consiglio dell'esperto: a volte i clienti non si convertono per qualcosa che va individuato in un passaggio precedente a quello che stai considerando.

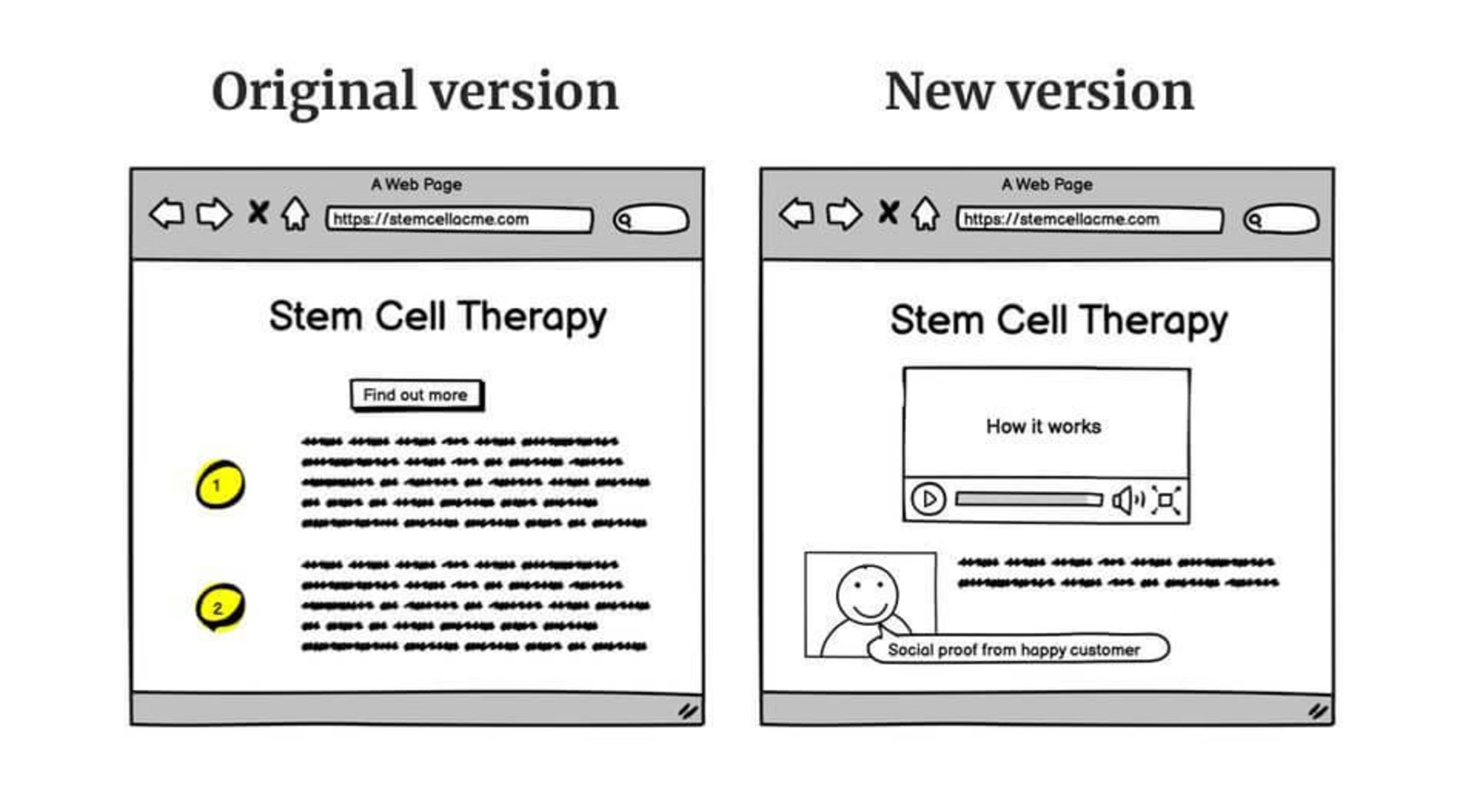

Ad esempio, Gavin, Managing Director di Yatter, agenzia di lead generation, ha analizzato il sito web di un cliente che offre terapie a base di cellule staminali, un prodotto molto costoso e ad alto impatto. Ha quindi notato che, nonostante il traffico elevato, la maggior parte dei potenziali clienti abbandonava in fase di pagamento.

Guardando le riproduzioni delle sessioni, Gavin ha notato che gli utenti dedicavano molto tempo alla lettura delle informazioni sul prodotto. Ha capito che il problema di conversione non riguardava la pagina di pagamento, ma il fatto che i clienti non erano ancora convinti, anche dopo aver letto le informazioni presenti sulla pagina di prodotto.

Ha quindi aggiunto una serie di case study e di video informativi, registrando un aumento del 10% nelle conversioni.

Il vecchio sito di Yatter in confronto alla nuova versione migliorata

3. Eseguire il test senza un numero adeguato di utenti

I test A/B sono un tormentone nei media dedicati al product management e al marketing, tanto da indurre molti a credere che siano la soluzione ideale per ogni azienda digitale. Questo, però, non è vero.

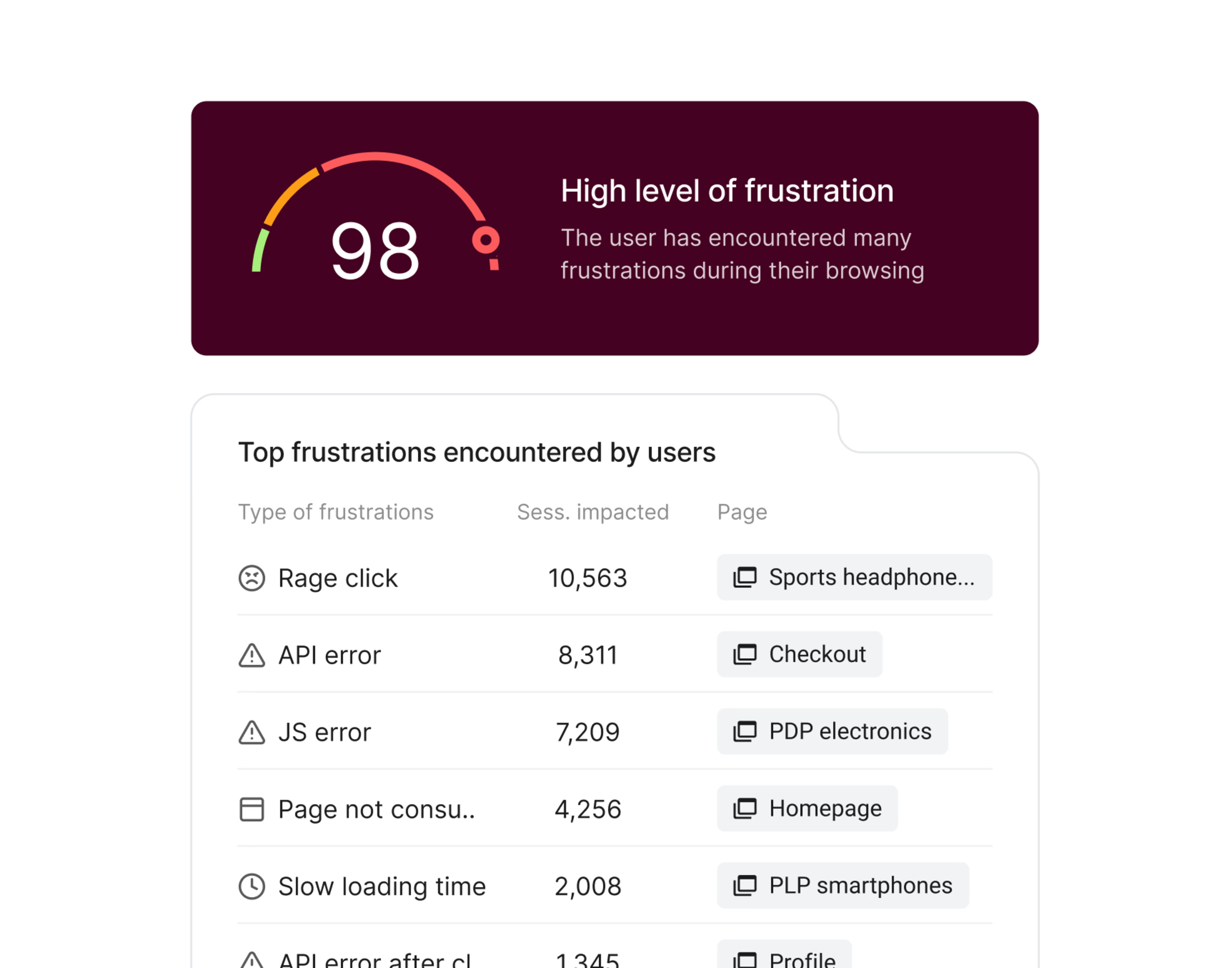

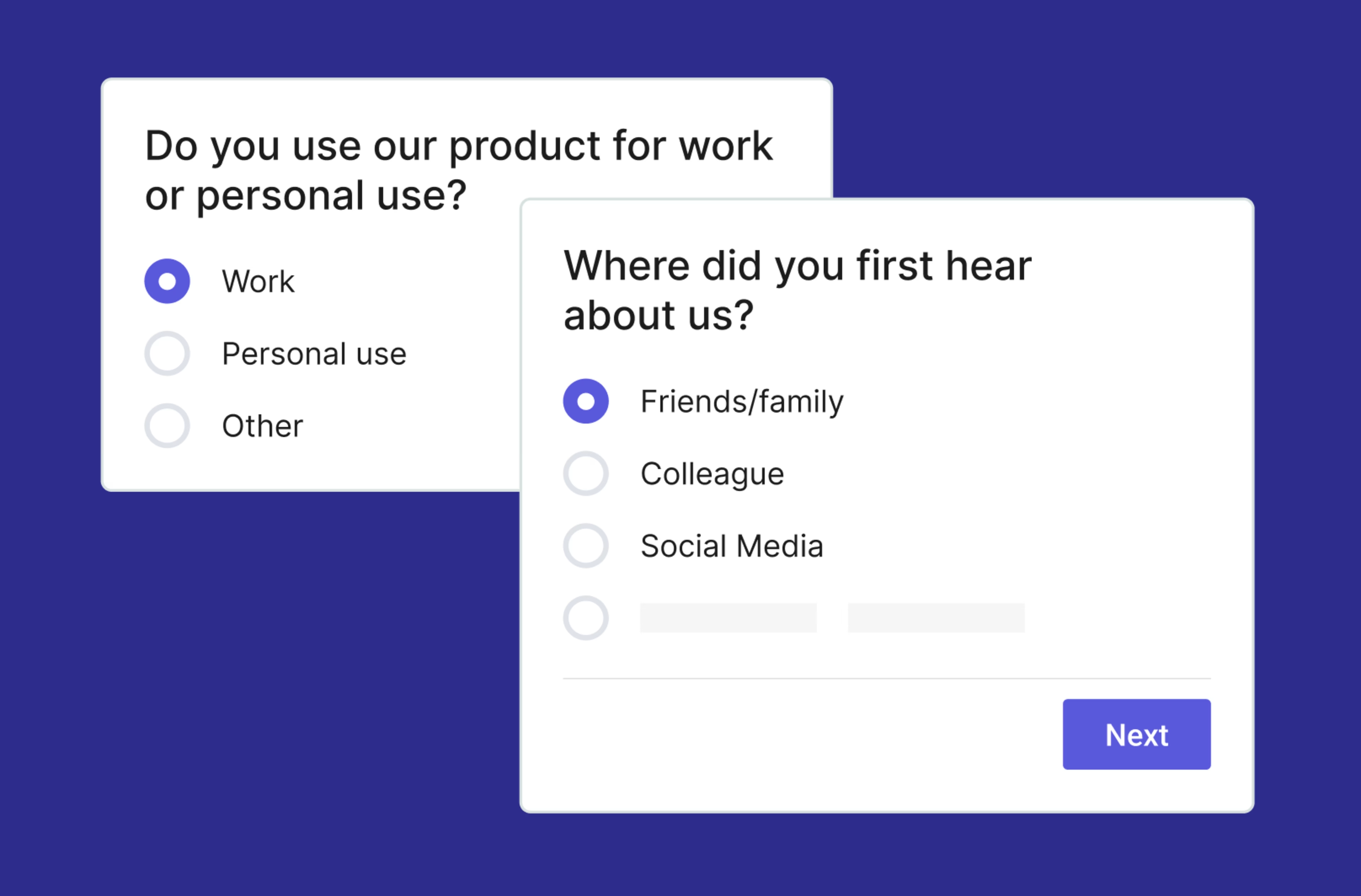

A meno che la pagina non abbia un notevole traffico settimanale, il test A/B non può raggiungere risultati statisticamente significativi. Nel settore si considera che una probabilità del 95% è "statisticamente significativa", ovvero se si esegue l'esperimento 20 volte, è probabile che si ottengano gli stessi risultati 19 volte.

Sono molti i tool per i test A/B che inviano automaticamente una notifica quando il test ha raggiunto tale valore soglia.

Come risolvere il problema: un calcolatore della dimensione del campione ti permette di verificare se il traffico e le conversioni sono sufficienti per condurre un test statisticamente significativo. Ti consigliamo quello di Neil Patel o quello di CXL.

Se il traffico non è sufficiente, non dimenticare che i test A/B non sono l'unica soluzione esistente per l'ottimizzazione del tasso di conversione (CRO).

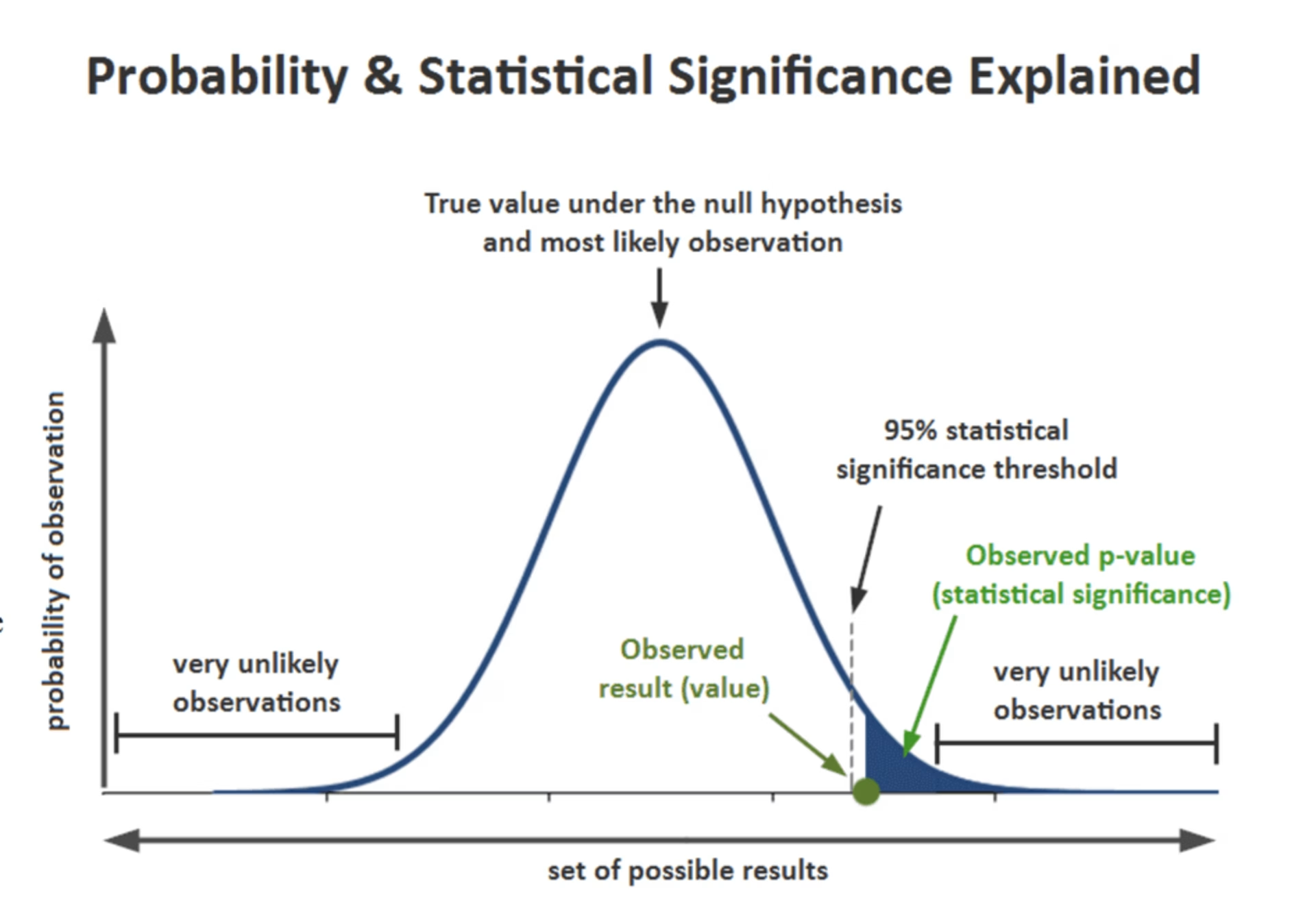

Puoi infatti chiedere direttamente ai clienti tramite un sondaggio o usare una heatmap di scorrimento per vedere fino a che punto della pagina i clienti arrivano di solito.

4. Non considerare il traffico su dispositivo mobile

La tentazione di darà priorità alla versione del sito per PC è forte, ma è anche un errore piuttosto grave. Nel 2022, gli utenti su mobile hanno generato più del 60% del traffico web.

Questa trascuranza è la causa di due dei peggiori errori da fare durante un test A/B:

Nel formulare le ipotesi, ci sono team che non prendono affatto in considerazione i dati ricavati dalle analytics per la versione mobile del sito. Questo significa che possono fare dozzine e dozzine di test, limitando comunque l'ottimizzazione solo al 40% dell'user experience.

Altri team, invece, eseguono i test A/B su modifiche al design o su nuove funzionalità e, pur di lanciare qualcosa il più velocemente possibile, non verificano come queste appariranno sui dispositivi mobili. Questo porta spesso a un'ipotesi completamente basata ed esaminata dal punto di vista della versione per PC, con risultati spesso incredibilmente scarsi. L'idea potrebbe sembrare geniale su desktop, ma risultare bruttina su iOS.

Come risolvere il problema: non dimenticare di dedicare un po' di tempo alla versione mobile del sito. Ecco come fare:

Durante la configurazione di un test A/B e prima di lanciarlo, è importante andare a guardare come appare su mobile. Molte piattaforme di test mettono a disposizione semplici strumenti proprio a tale scopo. Ad esempio, se avvii un test A/B in Optimizely, hai a disposizione uno strumento di anteprima che consente di vedere come le modifiche appaiono su altri dispositivi.

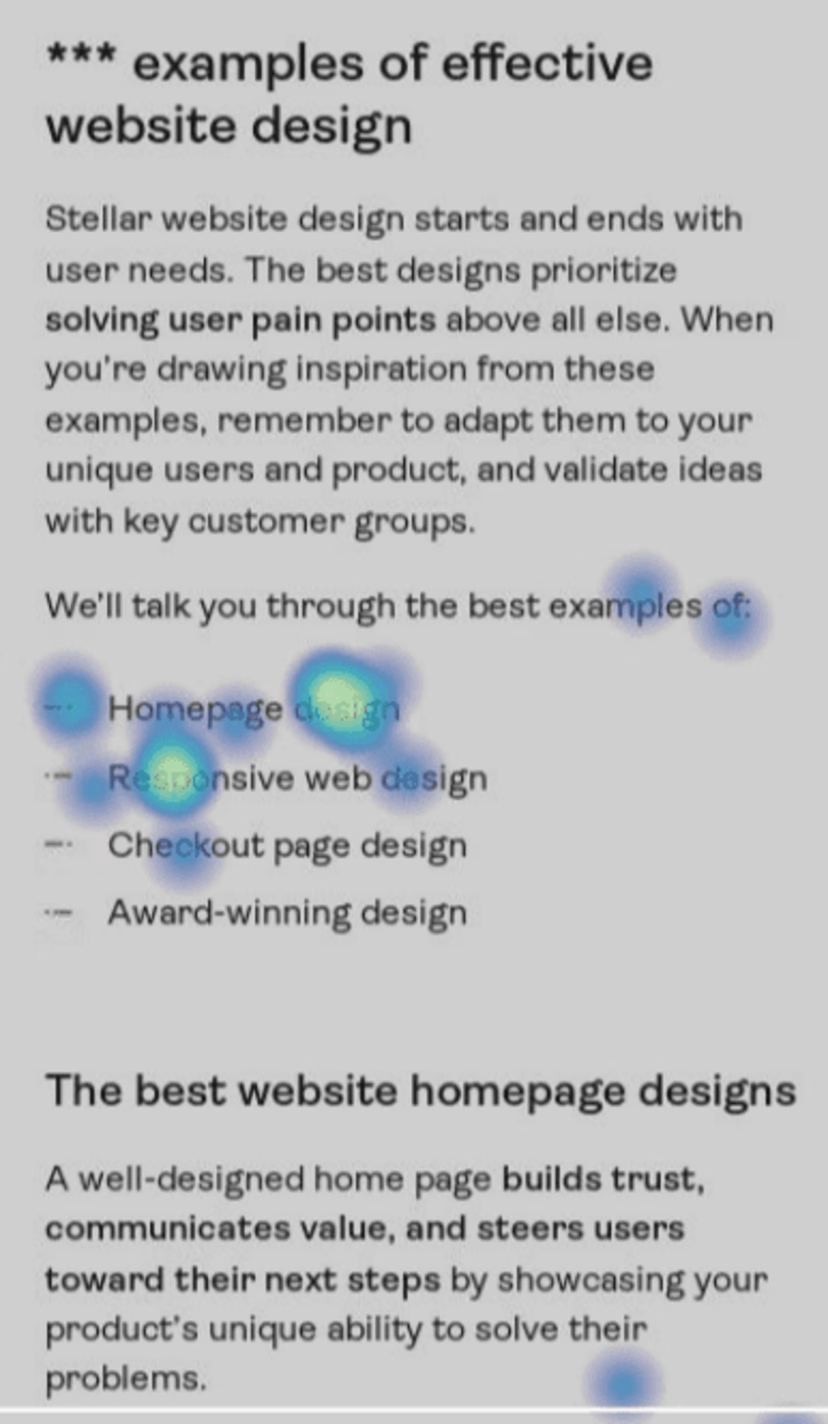

Quando esamini i dati del sito per sviluppare ipotesi, filtrali per dispositivo. Molte piattaforme con cui si ottengono insights sugli utenti, inclusa quella di Contentsquare, permettono di segmentare i dati usando proprio questo criterio. Allo stesso modo, è possibile filtrare le riproduzioni e le heatmap per vedere come gli utenti navigano sulla versione mobile del sito.

Ad esempio, guardando la heatmap qui sotto, è evidente che gli utenti provano a cliccare sui punti elenco "Homepage design" e "Responsive web design". Questo potrebbe indicare la necessità di aggiungere un numero maggiore di link di ancoraggio ai contenuti, per dare a chi legge la possibilità di trovare più rapidamente quello che gli serve.

Una heatmap di Hotjar, parte del gruppo Contentsquare, che mostra dove gli utenti cliccano su mobile quando leggono una guida su esempi di web design

Errori in fase d'esecuzione

È fondamentale che il test sia avviato senza errori e in modo efficace, ma ci sono diverse altre insidie da evitare durante l'esecuzione.

5. Testare troppe ipotesi contemporaneamente

Testare più elementi della pagina contemporaneamente può sembrare un'ovvia soluzione per risparmiare tempo e aumentare rapidamente le conversioni di una pagina, ma potrebbe causare più problemi di quanti ne risolve.

Ecco un esempio di cosa significa avere "troppe ipotesi": immagina di voler aumentare le vendite di un online store. Decidi di eseguire un test A/B su una pagina di prodotto, dove la versione "A" corrisponde a quella attualmente in uso e la variante "B" include:

Un banner di offerta.

Un pulsante "Acquista ora" più grande.

Informazioni supplementari sul prodotto.

Non saprai mai quale modifica ha portato ai risultati osservati e rischi di sprecare solo tempo e risorse, implementando modifiche senza avere prove che queste portino a un aumento delle conversioni.

Spesso si sente la pressione di ottimizzare il sito in tempi brevi, specialmente nel caso delle startup, ma per ottenere risultati utili dai test A/B serve pazienza.

Come risolvere il problema: esegui i test A/B uno alla volta, in modo da trarre le lezioni più importanti da ciascuno e procedere in modo metodico. Bisogna anche ricordare che i test A/B non sono l'unico modo per verificare cosa ne pensano gli utenti delle modifiche e di certo non il più veloce.

Ecco cos'altro fare:

Se il sito registra abbastanza traffico e non c'è altra alternativa che testare più di un elemento alla volta, magari per il lancio di un nuovo design per il quale è necessario capire se tutto funziona come dovrebbe, allora prova i test multivariati. In questo caso, il traffico del sito web viene suddiviso in segmenti più piccoli: quindi, invece di un test A/B, puoi fare un test A/B/C/D.

Se il traffico è ridotto, chiedi ai clienti di valutare i cambiamenti radicali alla vecchia maniera: con un sondaggio.

Con Contentsquare puoi lanciare e monitorare il tuo sondaggio Net Promoter® Score in tutta semplicità

6. Eseguire il test per un periodo di tempo troppo breve

Abbiamo visto cosa succede se si esegue un test A/B con pochi utenti. Allo stesso modo, interrompere il test troppo presto può risultare in dati non significativi. Anche in questo caso, è fondamentale raggiungere la significatività statistica, ovvero almeno il 95% di probabilità che i risultati non siano dovuti al caso.

È facile lasciarsi tentare dall'idea di interrompere un test A/B che fin dall’inizio sembra avere successo, specie nei casi in cui si considera particolarmente attendibile l'ipotesi iniziale. Senza la significatività statistica, questa decisione potrebbe risultare rischio. Più sono i dati raccolti, più precisi sono i risultati.

Un'esemplificazione grafica della significatività statistica. (Fonte)

Come risolvere il problema: resisti alla tentazione e non interrompere il test A/B prima di aver ottenuto il numero magico: il 95% di significatività statistica. La maggior parte delle app per i test A/B segnala automaticamente la versione vincente quando si raggiunge questo valore soglia.

Un approccio ancora più rigoroso è quello di aspettare di aver raggiunto la dimensione minima del campione calcolata in precedenza, come indicato nel terzo punto.

7. Non rendersi conto che lo strumento di test rallenta la velocità del sito

Alcuni strumenti di test A/B possono rallentare il sito, anche se solo di qualche secondo. In effetti, suddividere gli utenti tra due versioni del sito aggiunge un ulteriore passaggio al caricamento della pagina. Per di più, va considerato che il 40% degli utenti abbandona un sito che impiega più di 3 secondi a caricarsi, cosa che potrebbe compromettere seriamente le metriche.

Generalmente, se il sito rallenta, il tasso di conversione diminuisce di conseguenza, così come aumenta la frequenza di rimbalzo.

La buona notizia è che si tratta solo di un problema temporaneo: il sito torna alla sua normale velocità di caricamento una volta terminato il test A/B e disattivato lo strumento. Il pericolo sta nel non rendersi conto di cosa sta succedendo.

Come risolvere il problema: esegui un test A/A prima del test A/B. Puoi avviare il software di test in background sulla pagina senza eseguire un esperimento. Molti tra gli strumenti di test più gettonati, tra cui Optimizely, supportano questa funzione.

Un test A/A permette di:

Verificare se lo strumento per i test A/B rallenta la pagina o ha un impatto negativo sulla metrica da testare.

Accertarsi che le impostazioni del tool siano corrette, con la consapevolezza che il test A/A dovrebbe risultare sempre in un pareggio.

Se necessario, considera nei risultati la riduzione della velocità del sito o se prevedi di eseguire spesso test A/B, trova uno strumento più adatto.

Errori in fase di valutazione

È possibile commettere errori anche dopo aver pianificato ed eseguito i test A/B. Ecco alcuni errori da evitare, quando converti i dati appena raccolti in azioni concrete.

8. Non lasciare traccia del lavoro svolto e dei risultati ottenuti

Tra il fatto che bisogna aspettare di avere una significatività statistica e la possibilità di modificare un solo elemento alla volta, i test A/B richiedono un notevole sforzo e tante energie ed è quindi importante imparare il più possibile da ognuno di questi.

Redigere una documentazione completa ti aiuta a:

Scoprire quali sono le idee che funzionano meglio.

Gestire al meglio le risorse.

Avere più consapevolezza durante l'elaborazione della futura strategia di prodotto.

Come risolvere il problema: crea un template per la documentazione dei test A/B interni, assicurandoti che tutti seguano la procedura. Il template dovrebbe includere:

I dati delle analytics che hanno contribuito alla formulazione dell'ipotesi.

Le supposizioni sul motivo per cui i dati si presentano in questo modo.

L'ipotesi espressa come un'affermazione esplicita e chiara.

Le metriche che si vogliono misurare.

I risultati del test, inclusa una discussione e un elenco di azioni da compiere successivamente.

Il documento che risulta dal test A/B dovrebbe essere un report di massimo una pagina e di facile consultazione. Una volta redatto il resoconto del test, questo va condiviso con il resto dell'azienda, aspettandosi un feedback da parte dei colleghi.

9. Non iterare sul test

Se un test A/B contraddice l'ipotesi formulata, la tendenza è di scrivere il report, scrollarsi di dosso la faccenda e passare immediatamente ad altro, soprattutto se hai passato settimane a vedere l'ipotesi fallire miseramente e non ne puoi più. Tuttavia, questo approccio non lascia spazio alla riflessione su quanto si è imparato.

Come risolvere il problema:

Se la tua ipotesi, supportata dai dati relativi a un pain point dei clienti, viene confutata da un test A/B, cerca un'altra opzione. Il problema che hai identificato persiste: semplicemente non hai trovato al primo tentativo la soluzione giusta.

Se l'ipotesi resta valida, considera allora la possibilità di procedere con un'ulteriore iterazione. Se trovi una strategia che funziona, perché non puntare ancora più in alto? Ad esempio, se testi un carosello di immagini sulla pagina di prodotto e questo risulta in un aumento significativo delle conversioni, perché fermarsi? Il prossimo passaggio potrebbe essere, ad esempio, un test A/B di un video sul prodotto.

Non sai perché l'ipotesi non è stata confermata? Chiedilo agli utenti!

Se l'ipotesi formulata si basa su dati affidabili, un test A/B che la smentisce può essere percepito come una delusione. È però proprio in questi casi che vale la pena di approfondire la faccenda. Usa un sondaggio sulla pagina per chiedere agli utenti più informazioni sul loro comportamento.

Per esempio, supponiamo che tu voglia aumentare le vendite di affiliazione su un sito web che aiuta a trovare una persona con cui condividere un appartamento in città. I dati indicano che molti utenti abbandonano durante la registrazione. La tua ipotesi è che gli utenti siano scoraggiati dall'obbligo di acquistare una membership mensile, quando trovare un coinquilino è qualcosa che in genere richiede solo una settimana. Decidi quindi di testare con un test A/B le performance di una membership settimanale. Tuttavia, i risultati mostrano che non ci sono miglioramenti nel numero di conversioni.

Anziché abbandonare completamente l'idea, decidi di impostare un sondaggio sull'exit-intent sulla pagina di registrazione, in modo da chiedere agli utenti perché hanno deciso di non acquistare la membership. Scopri così che gli utenti non apprezzano il fatto di dover creare un profilo prima di poter affiliarsi.

Se così fosse, la prossima iterazione del test A/B dovrebbe puntare a ridurre la frizione nel processo di registrazione, invece di abbassare il prezzo o la durata dell’affiliazione.

Puoi attivare i sondaggi Contentsquare in modo da farli apparire quando gli utenti eseguono una determinata azione sul sito, ad esempio interrompere la procedura in fase di pagamento.

10. Apportare un numero eccessivo di modifiche sulla base dei risultati

Se vuoi convincere il team di un'idea per una nuova funzionalità o una modifica al design, un test A/B che ottiene risultati convincenti sarà capace di persuaderli. Tuttavia, quando ci sono dati a supporto, ci si sente spesso molto sicuri delle proprie decisioni sul prodotto, tanto da sopravvalutare le implicazioni dell'esperimento svolto.

Per esempio, immaginiamo di voler aumentare le iscrizioni a una mailing list. Tramite un test A/B, scopriamo che inserire un pop-up d'iscrizione nella pagina "Chi siamo" aumenta i valori della metrica. Basandosi su questi dati, si decide quindi di aggiungere un pop-up a ogni pagina del sito. Il trend potrebbe continuare ottenendo più iscrizioni, ma con un notevole aumento della frequenza di rimbalzo perché gli utenti che navigano sul blog trovano fastidioso il fatto di dover vedere un pop-up per ogni articolo su cui cliccano.

Come risolvere il problema: quando si apportano modifiche basando la decisione sui dati, è bene procedere con calma. Ricorda che un test A/B risponde solo a una specifica domanda e che modifiche su tutto il sito richiedono particolare attenzione e prudenza.

L’accuratezza dei test è fondamentale per sviluppare strategie efficaci per la crescita aziendale.

I test A/B richiedono pazienza, ma i risultati ti aiutano a garantire che ogni modifica si traduca in un incremento del fatturato. Va detto, tuttavia, che il test A/B non è il tuo unico asso nella manica.

Gli strumenti che ti aiutano a raccogliere insights sulla digital experience, ad esempio le heatmap, le riproduzioni delle sessioni e i sondaggi, sono molto utili per capire quali sono le modifiche che favoriscono la conversione degli utenti e quali elementi dell'ipotesi sono errati (o corretti!). Guardando qualche riproduzione delle sessioni degli utenti che cliccano sulla pagina di pagamento, è possibile notare molto rapidamente quali aree hanno bisogno di essere ottimizzate.

Il modo più efficiente per ottimizzare il sito è quello di applicare tutte le precedenti strategie in maniera congiunta: puoi così capire meglio i risultati dei test A/B e ottenere insights di digital experience per formulare le migliori ipotesi per i test A/B.

Domande frequenti sugli errori nei test A/B

Quali sono i limiti dei test A/B?

Il test A/B è una strategia molto apprezzata per introdurre piccole modifiche al prodotto, in modo da incrementare costantemente le conversioni, ma ci sono comunque alcune limitazioni da considerare.

Richiedono molto tempo: con ogni esperimento si può testare solo un'ipotesi. A seconda delle dimensioni del pubblico, il test potrebbe durare fino a otto settimane. Se vuoi ottimizzare ogni singolo elemento di una pagina tramite i test A/B, il progetto durerà mesi se non anni.

Potrebbe non essere efficace su siti con poco traffico: senza un flusso consistente di visitatori sul sito, i test A/B tendono a non raggiungere la significatività statistica. Questo vuol dire che i dati raccolti potrebbe essere dovuti semplicemente al caso.

Non è indicato per testare modifiche che operano una trasformazione profonda: il test A/B può rispondere solo a una domanda del tipo "preferisci questo o quello?". È utile per capire se una piccola modifica al copy o al design può migliorare le conversioni, ma non fornisce risultati abbastanza dettagliati per essere usati quando si vogliono apportare importanti modifiche strutturali.

Non è in grado di spiegare il "perché" che giustifica i numeri ottenuti: anche se la versione B del test A/B ottiene performance migliori, questo non significa che si ha la certezza assoluta della correttezza dell'ipotesi su cui si basava. La versione modificata del sito potrebbe avere risultati migliori rispetto all’originale per un motivo che non hai considerato.

Molte delle limitazioni dei test A/B possono essere risolte integrando i risultati con dati qualitativi sul comportamento degli utenti sul sito.

I risultati dei test A/B sono accurati?

Sì, i test A/B sono accurati, a condizione di avere un numero sufficiente di utenti per trovarsi entro la soglia di errore standard per il settore.

La maggior parte delle aziende ritiene che i risultati dei test A/B possono essere ritenuti affidabili quando un esperimento raggiunge il 95% di significatività statistica, cioè quando abbastanza persone hanno partecipato all'esperimento da poterlo ripetere 20 volte e ottenere lo stesso risultato in 19 casi.

Cosa fare se i risultati dei test A/B non sono significativi?

Se il test A/B non raggiunge la significatività statistica, significa che non ci sono abbastanza dati per stabilire con certezza se la nuova versione del sito registra un numero maggiore d'utenti rispetto a quella precedente. Per aumentare le probabilità di ottenere risultati significativi, l'accorgimento più importante, se hai voce in capitolo, è di ampliare la dimensione del campione, prolungando la durata del test o portandolo all'attenzione di un numero maggiore di utenti.

È possibile che i risultati dei test A/B non raggiungano mai la significatività statistica. In tal caso ci sono due possibilità: l'ipotesi non ha avuto un impatto positivo significativo sulle metriche di conversione o il test non è stato eseguito con un numero sufficiente di utenti per generare risultati attendibili.

Per verificare se quest'ultimo è il problema che stai affrontando, puoi usare un calcolatore della dimensione del campione per verificare quanti utenti devono partecipare al test per renderlo statisticamente significativo.

Se l'ipotesi è stata testata con un numero sufficiente di persone, significa allora che non ha aumentato le conversioni al punto da generare un impatto misurabile. A volte si vince, a volte si perde! Passa di nuovo al setaccio i dati nelle analytics per capire perché l'ipotesi è stata smentita e rifletti su una nuova iterazione che riesca a ottenere un impatto significato sui dati.

![[Visual] Contentsquare's Content Team](http://images.ctfassets.net/gwbpo1m641r7/3IVEUbRzFIoC9mf5EJ2qHY/f25ccd2131dfd63f5c63b5b92cc4ba20/Copy_of_Copy_of_BLOG-icp-8117438.jpeg?w=1920&q=100&fit=fill&fm=avif)