ABテストは、ウェブサイトをビジネス成果に向けて最適化するためのアイデアを検証する、信頼性の高い定番手法です。 ユーザーに価値のあるコンバージョンアクションを促すうえで、非常に効果的です。

ABテストの結果が良好であれば、それは、あなたが考えている変更が、より多くの顧客にあなたとビジネスをする気にさせるという確かなサインです。たとえば、ECサイトでの商品動画をテストする場合でも、オンラインマガジンの新しいサブスクリプションバナーをテストする場合でも同じです。

しかし、よくあるABテストのミスを1つでも犯してしまうと、信頼できないデータが得られ、戦略が間違った方向へ進んでしまう恐れがあります。

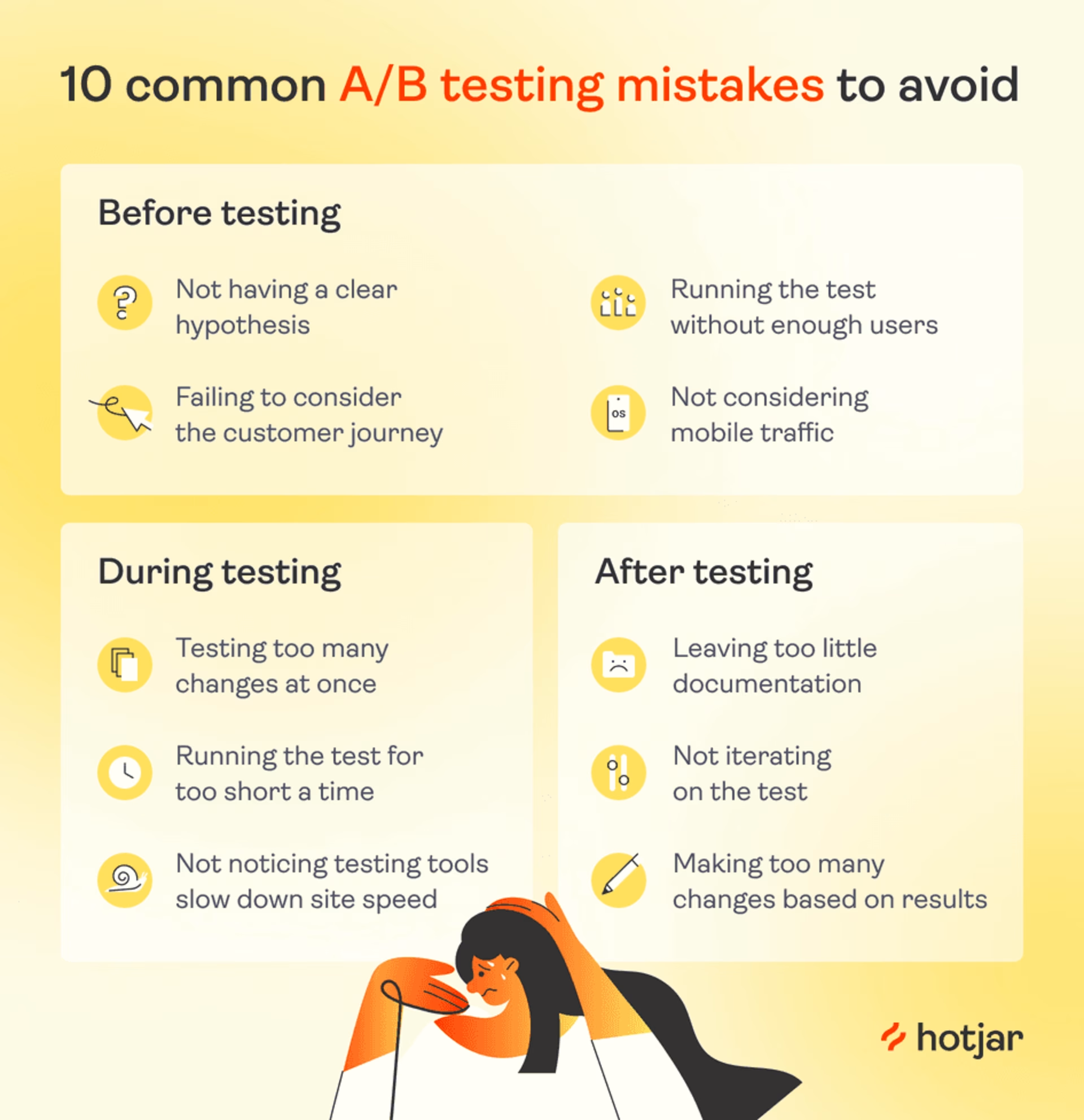

正しい判断につながる「クリーンなデータ」を得るために、避けるべき10のミスを紹介します。

それらは3つのカテゴリーに分かれています。

テスト前のミス

テスト中のミス

テスト後のミス

テスト前のミス

ABテスト(スプリットテストとも呼ばれる) では、ランダムにユーザーに2つのバージョンのWebページを表示します。1つは従来の「コントロール(標準)」、もう1つは新しいバリアントで、より多くのユーザーに望ましいアクションを取ってもらうことを目的としています。

ABテストを成功させるには、実行前の計画段階から慎重に仮説とテスト条件を検討することが重要です。 以下に、テストを開始する前によくある落とし穴と、それを回避する方法を紹介します。

1.明確な仮説を持たない

「なんとなく良さそうだから」と思って変更を加え、テストを始めるのは簡単です。 しかし、ABテストは明確な問い(クローズドな問い)に対して答えを出す仕組みであるため、仮説があいまいでは意味がありません。

仮説がないと、結果が出ても目的と関係ない指標に気を取られてしまう危険があります。たとえば「ページ滞在時間が増えた」という結果ばかり見て、肝心のコンバージョン改善ができていないことに気づかない、というようなことです。

どう解決するか:成果のあるABテストには、「何を・なぜ改善するのか」を明文化した仮説が必要です。

仮説は if-then(もし〜なら、〜になる) の形式で書くと明確になります。例:「『カートに追加』ボタンをより目立たせたら、より多くのユーザーがコンバートするはず」

仮説を立てる際に必要なことが3つ。

ステップ1.ウェブ解析データを掘り下げる コンバージョンに至るまでのユーザーの行動を観察する。例:「チェックアウトを開始したユーザーの95%が、カード情報入力前に離脱している」

💡 プロのヒントコンテンツスクエアのようなエクスペリエンス・インテリジェンス・プラットフォームは、ここで貴重な詳細情報を提供してくれます。

Product Analyticsダッシュボードで直帰率、平均セッション時間、人気ページなどの主要指標を確認します。また、ヒートマップやセッションリプレイを活用し、ユーザーがなぜそのような行動を取っているのかを可視化します。

ステップ2.ユーザーがコンバートしない理由を推測する。-入手可能な情報に基づく、あなたの最善の推測

「古いデザインのままの決済ページに不安を感じ、カード情報の入力をためらっているのではないか」

ステップ3.ユーザーの行動を変えるための変更案に基づいた仮説を立てる。

例:「決済ページに『セキュア決済』のアイコンを追加すれば、より多くのユーザーがコンバートするはず」

行動データ → 仮説 → ABテスト → 成果向上

セッションリプレイを使えば、顧客がどこを移動し、どこをクリックしたかを見ることができるので、顧客が期待した行動を取らない理由を理解することができます。

事例:オンラインバナー作成ツールBannersnack Bannersnackの機能では、セッションリプレイを使っていくつかの強力な仮説を立証しました。

例:新たに追加した「タイムラインビュー」機能に、既存ユーザーがほとんどアクセスしていないことにアナリティクスで気づく。

リプレイを見てみると、「タイムライン表示」ボタンが非常に目立たないため、ユーザーが存在自体に気づいていないことが判明。

そこで立てた仮説: 「『タイムライン表示』ボタンを大きくすれば、より多くのユーザーが使ってくれるはず」

そこでBannersnackチームはこの仮説をABテストで検証した結果、この小さな変更だけで機能の利用率が12%アップしました。

![[Visual] Session Replay - What is CSQ?](http://images.ctfassets.net/gwbpo1m641r7/3XsaMYdpHjNeBE8x4r219k/eb9e7ae1ae4a0f3c0eedb754b9d23853/Session_Replay.png?w=3840&q=100&fit=fill&fm=avif)

セッションリプレイにより、実際のユーザーがサイト内をどのように移動するかを把握できます。

2.カスタマージャーニーを考慮しない

指標を動かす可能性のあるものをA/Bテストするようにしましょう:

ABテストを実施するなら、指標に実際に影響を与える可能性のある部分を選びましょう。テスト対象として適しているのは、トラフィックが多く、コンバージョンファネルに直結している重要なページです。

一方で、「会社概要ページ」のようなアクセス数が少なく、ビジネス成果に直結しないページをテストしても、結果から大きな改善インパクトを得ることは難しいでしょう。

カスタマージャーニーマップ(顧客がコンバージョンに至るまでのステップ)を見直しましょう。

広告をクリックする

製品ページのレビュー

配送情報の閲覧

これによって、顧客がすでにコンバージョンを決定した後、あるいはコンバージョンを決定する前であるときにしか目にしないページの最適化に労力をかけすぎることを防ぐことができます。

(どこか懐かしい“ローテク”な)カスタマージャーニーマップ

解決方法:カスタマージャーニーマップを踏まえて、仮説を立てましょう。ABテストを実施しようとしているページがあるなら、自問してみてください:

この時点で、ユーザーはすでにどのような決断を下しているのだろうか?

ユーザーはまだコンバージョンの意思決定プロセスにすら入っていない可能性はないか?

💡 プロのヒント: ユーザーがコンバートしない原因は、自分が想定している“そのページ”の一歩前にあることが多いです。

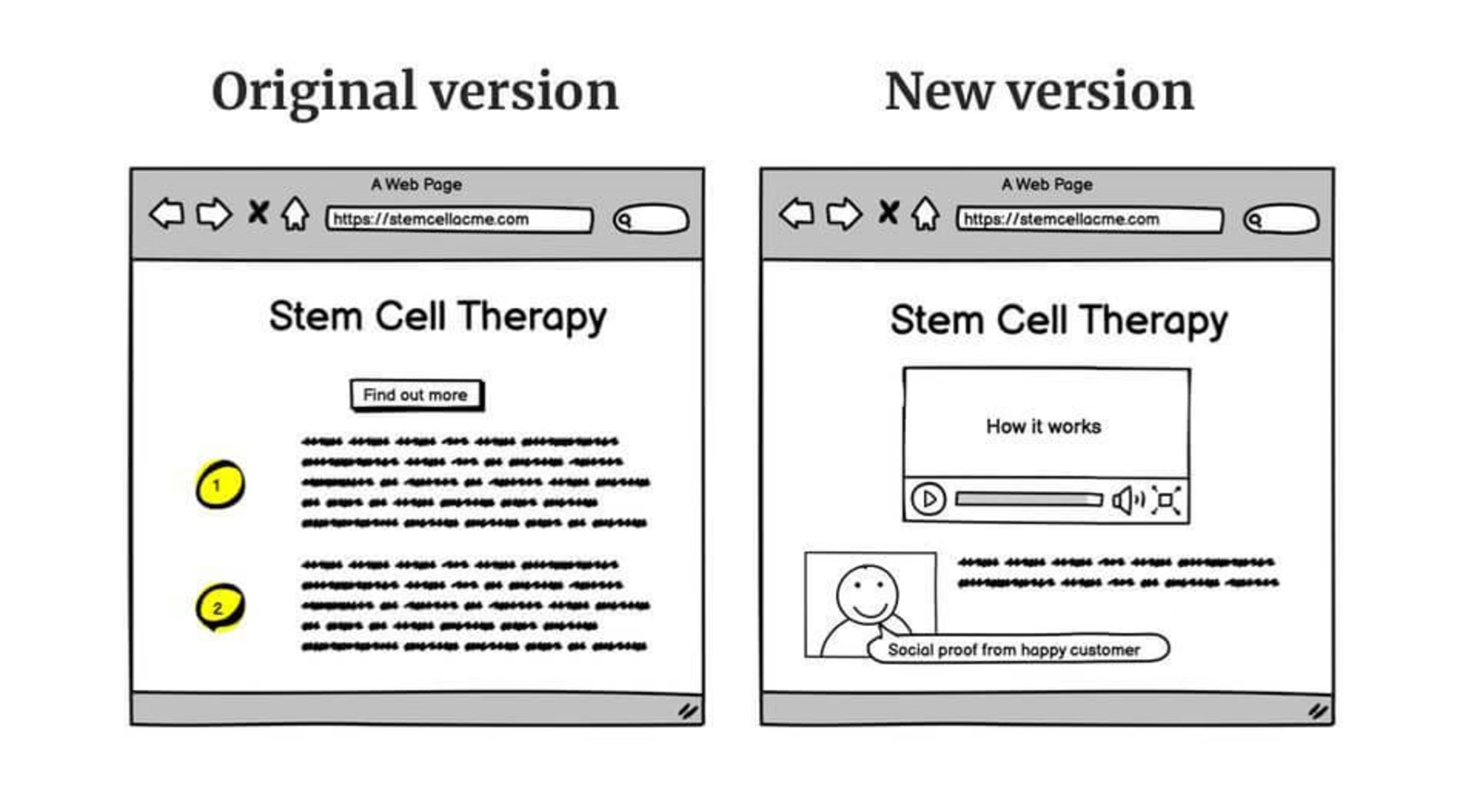

Yatter社のマネージングディレクター Gavin氏は次のように語っています。 Yatterは、幹細胞治療という非常に高価で高額な製品を販売する顧客のウェブサイトを見直したとき、多くのトラフィックがあるにもかかわらず、ほとんどの見込み客がチェックアウトの時点で離脱していることに気づきました。

セッションリプレイを確認したGavinは、ユーザーが商品説明ページを長時間かけて読んでいることに気付きました。 このとき、問題はチェックアウトページそのものではなく、「商品ページに説得力が足りず、購入を決断できなかった」ことが原因だと判断したのです。

そこで彼はケーススタディと説明ビデオを追加したところ、 コンバージョンが10%増加しました。

旧サイトと新しくなったサイト

3.十分なユーザー数を確保する前にテストを実行する

ABテストは、プロダクトマネジメントやマーケティング業界でしばしば「最強の手法」としてもてはやされます。 ですが実際には、すべてのデジタルビジネスにとって万能な手法というわけではありません。

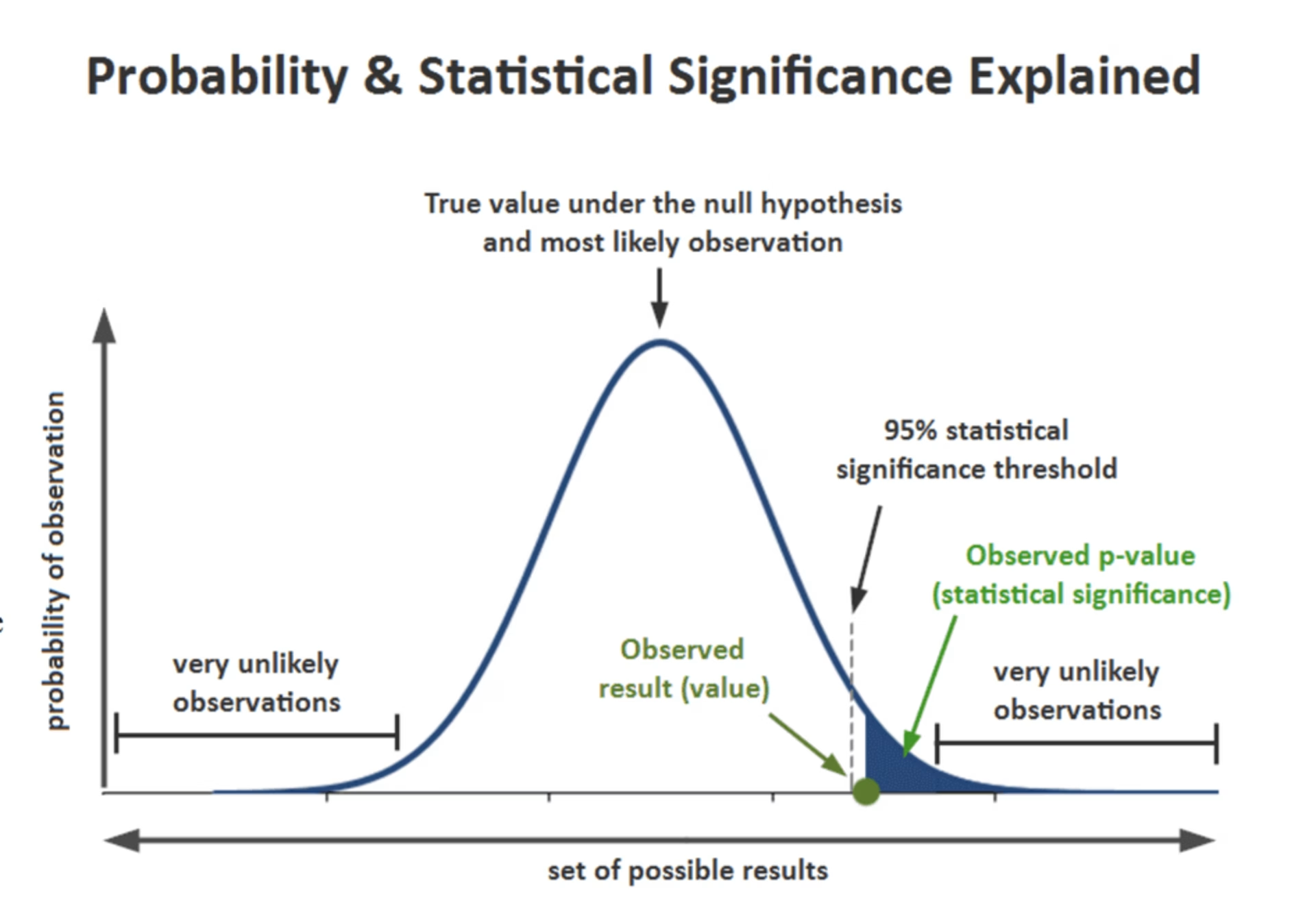

あなたのページに十分な週次トラフィックがない限り、ABテストで統計的に有意な結果を出すのは困難です。業界では、95%の確率で結果が再現されることを「統計的に有意」と見なします。つまり、同じテストを20回実施して、19回同じ結果になる確率です。

多くのABテストツールは、テストがこのしきい値に達すると自動的に通知を送信します。

解決方法: Neil PatelやCXLのようなサンプルサイズ計算機を使って、統計的に有意なテストを実行するのに十分なトラフィックとコンバージョンがあるかどうかを調べましょう。

十分なトラフィックがない場合: ABテストがコンバージョン率最適化(CRO)の全てではありません。

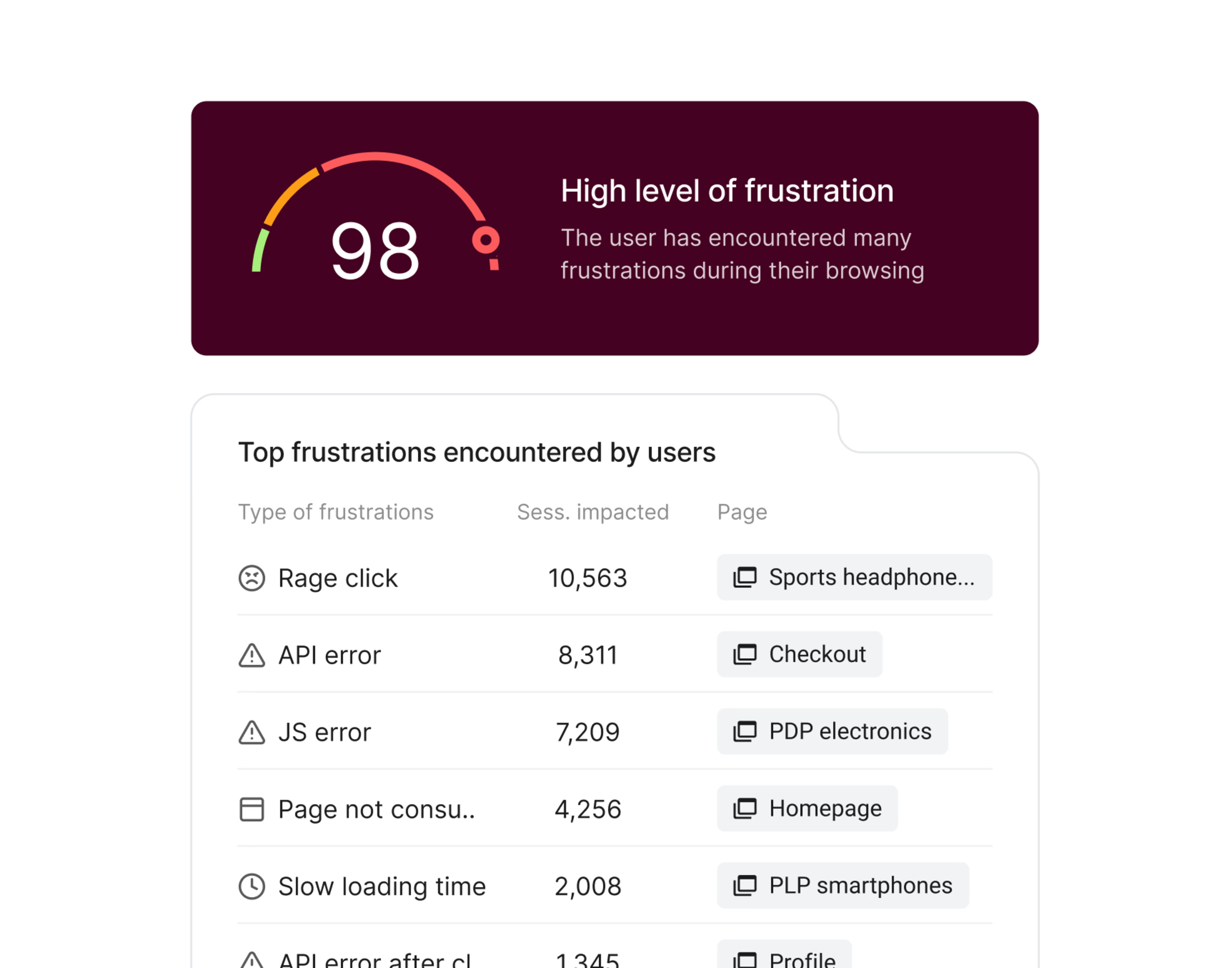

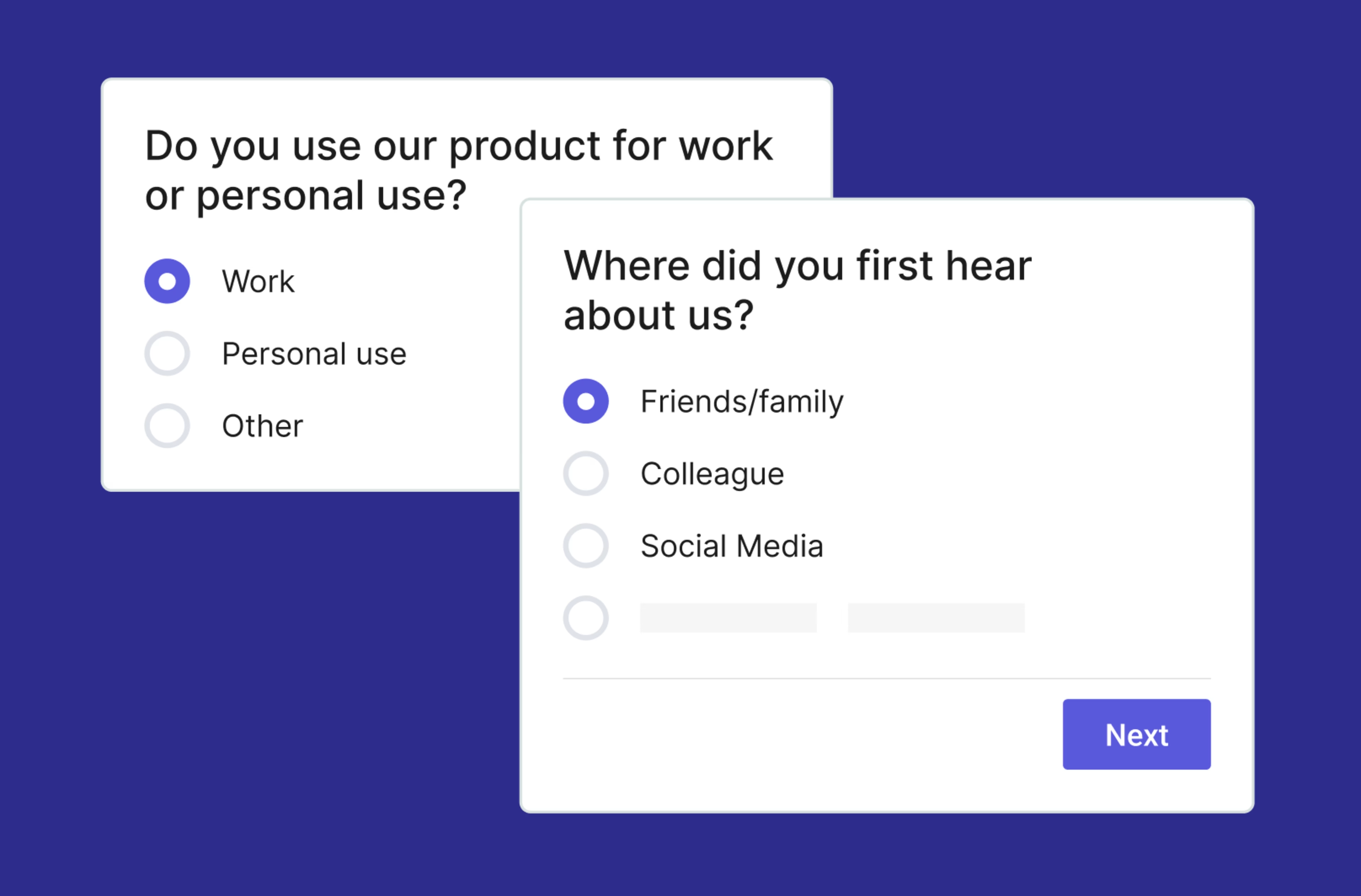

顧客にアンケートで直接ニーズを尋ねましょう。アンケートまたは、スクロールヒートマップを使って、お客様がページのどの辺りまで移動しているのかを確認してみましょう。

4.モバイルトラフィックを考慮しない

デスクトップ版のサイトを優先してしまうのはよくあることですが、これは致命的な見落としになり得ます。2024年時点で、ウェブトラフィックの60%以上はモバイルから発生しています。

この「モバイルの死角」が、以下のような2つのABテストのミスを生んでいます:

仮説を立てる際に、モバイル版サイトの分析データを掘り下げないチームもあります。そのため、何十回ものABテストを実施しても、ユーザー体験の40%しか最適化できていません。

一部のチームは、デザインの微調整や新機能のアイデアをABテストし、何かを発表することを急ぐあまり、それがモバイルでどのように表示されるかをチェックしません。その結果、デスクトップ版サイトではユーザー中心で熟考された仮説が、ABテストではどうしようもなく悪い結果になってしまいます。アイデアがヒットしなかったように見えるが、実際はiOSで悪く見えただけかもしれません。

解決方法:モバイル版の確認を、チームに徹底させましょう。

テスト設定前に、必ずモバイルでの見え方・操作感を確認する。Optimizelyなど多くのABテストツールでは、「プレビュー機能」で他デバイスでの表示確認が可能です

データ分析時は、デバイス別にフィルタリングして仮説を立てる。Contentsquareのようなユーザーインサイトプラットフォームでは、デバイス別のヒートマップやセッションリプレイを活用し、似ている行動を取ったスマホユーザーデータをセグメント化できます。

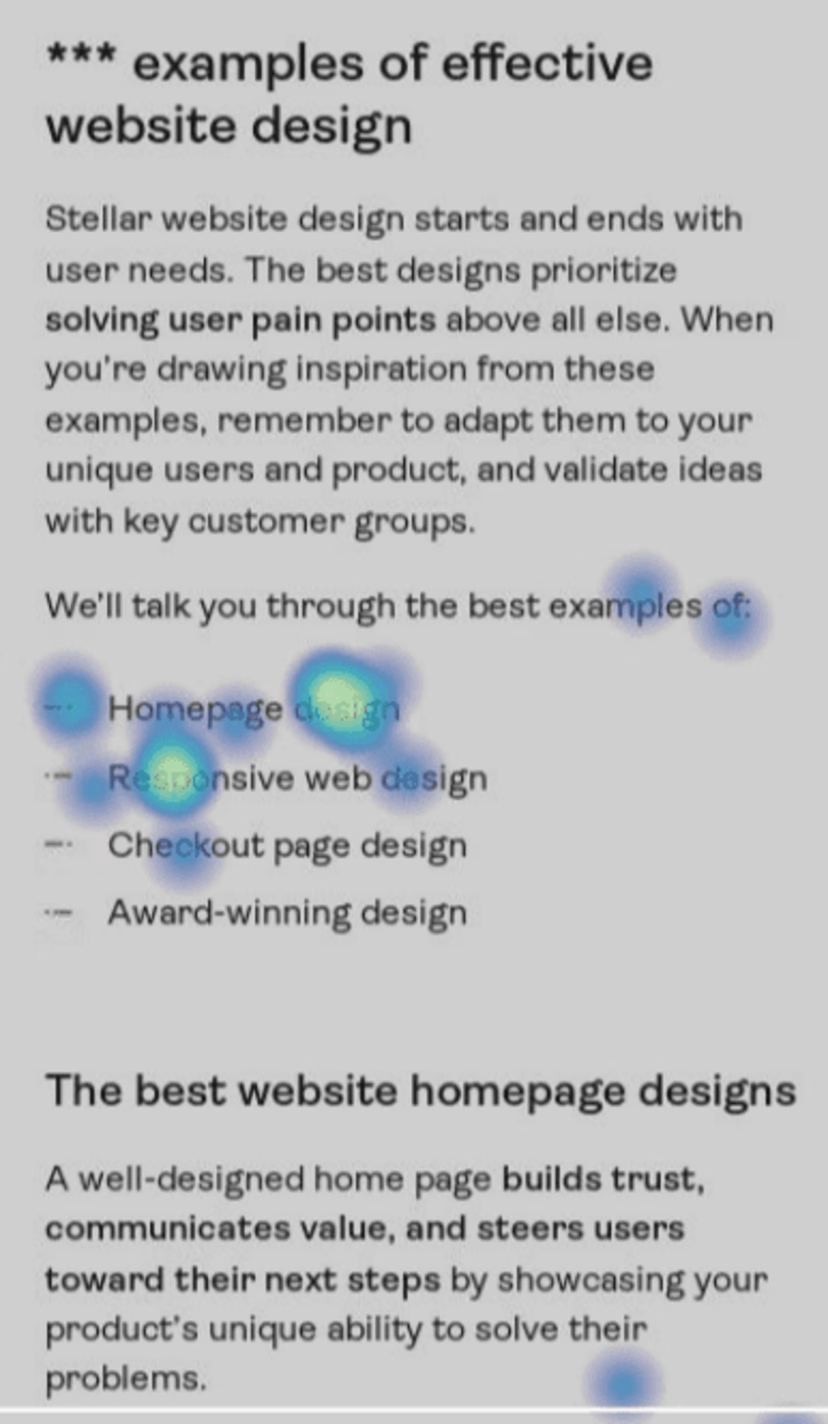

あるヒートマップでは、モバイルユーザーが「ホームページデザイン」や「レスポンシブWebデザイン」といった箇条書きにタップしようとしている様子が見られました。これは、ユーザーがジャンプリンク(ページ内リンク)を求めているサインかもしれません。その場合は、よりスムーズに情報にアクセスできるようにコンテンツ戦略を見直す必要があります。

Contentsquareグループ傘下のHotjarが、ウェブデザインの例に関するガイドを読む際に、ユーザーがモバイルでどこをクリックしたかをヒートマップで示したもの。

テスト中のミス

テストをエラーのない強力なスタートで始めることは重要ですが、立ち上げと実行中に避けるべき一般的な落とし穴がまだいくつかあります。

5.一度に多くの仮説を検証しすぎる

「複数の要素をまとめてテストすれば時間を節約できるし、すぐに成果が出そう」と思うかもしれません。ですが、それは逆に労力とコストの無駄になってしまう可能性が高いです。

「仮説が多すぎる」例: あなたがオンラインストアの売上アップを目指しているとします。商品ページでABテストを行い、以下のポイントを変更したい場合。:

オファーバナー

より大きな「今すぐ購入」ボタン

その他の製品情報

どの微調整が結果につながったかを知ることができないため、コンバージョンを増加させる根拠もなく変更を実施することになり、時間とリソースを浪費することになります。

スタートアップなどスピードが求められる環境では、サイトを早く最適化しなければというプレッシャーがかかることもあります。ですが、有益なABテストの結果を得るには、忍耐と計画性が不可欠です。

解決方法:1回のテストに1つの仮説だけを設定しましょう。そうすることで、テストから得られる学びが明確になり、次に進むべき改善点が判断しやすくなります。とはいえ、ABテストだけが「ユーザーに好まれるかどうかを検証する手段」ではなく、最も速い方法でもありません

その他にできることは以下の通り。

トラフィックが十分にある場合:どうしても複数の要素を同時にテストしたい場合(例:サイトの全面リニューアルなど)、多変量テストを検討しましょう。この手法では、ABテストではなくAB/C/Dといった複数バリエーションを比較し、要素ごとの効果を見極めることができます。

トラフィックが少ないならユーザー調査を使い、顧客に急進的な変化を評価してもたいましょう。

Contentsquareを使えば、サイト上で簡単にNet Promoter®スコア調査を開始し、モニタリングすることができます。

6.テストの実行時間が短すぎる

「ユーザー数が少ない状態でABテストを実施してしまう」のと同様に、テスト期間を途中で切り上げてしまうと、信頼性に欠ける結果になってしまいます。ここでも重要なのは、統計的に有意な結果(少なくとも95%の信頼水準)を達成することです。

ABテストを始めてすぐにポジティブな傾向が見えると、 「これは当たりだ!」と感じてテストを早めに終わらせたくなるかもしれません。特に、仮説に自信があるとその誘惑は強くなります。しかし注意すべきは:

統計的有意性がない限り、それは“ただの運”に過ぎない可能性があります。出典

修正方法:95%の統計的有意性に達するまで、途中でテストを止めないようにしましょう。ほとんどのABテストツールはこの閾値に達すると自動的に「勝者」を判定してくれます。

さらに確実を期すなら、事前に計算した最小サンプルサイズに達するまでテストを継続するのがおすすめです(これは3番目の項目でも紹介しました)。

7.テストツールがサイトスピードを遅くしていることに気づかない

ABテストツールによっては、サイトの表示速度が1秒遅くなるものもあります。結局のところ、あなたのサイトの2つの異なるバージョン間でユーザーベースを分割すると、ページ読み込みプロセスに余分なステップが発生します。さらに 40%ののユーザーが3秒以上かかるサイトを放棄すると言われています。

サイトが遅くなれば、コンバージョン率は下がり、直帰率は上がるでしょう。.

良いニュース:これは一時的な問題です。テスト終了後にツールを停止すれば速度は元に戻ります。危険なのは、何が起こっているのか気づかないことです。

解決方法:ABテストの前にAAテストを行いましょう。 つまり、ABテストツールを使ってページ上で何も変更しないまま、ツールの動作影響だけを測るテストです。Optimizelyなどの主要ツールでは、このAAテストが簡単に実施できます。

AAテストでは

ABテストツールによってページの表示が遅くなったり、テストしたい指標に悪影響がないか確認できます。

テスト結果にスピード低下の影響を加味する判断材料になります。

今後も頻繁にABテストを行う予定がある場合は、より軽量なツールを探す判断材料にもなります。

テスト後のミス

ABテストを入念に計画し、実施したとしても、ミスを犯す可能性はあります。ここでは、取得したばかりのデータを行動に移す際に避けるべきミスをいくつか紹介します。

8.文書が少なすぎる

ABテストは、統計的有意性を待ち、1つずつしか要素を変更できないため、時間と手間がかかるテストです。

記録を残す

どのアイデアが有効かを学ぶ

リソースの最大化

将来の製品戦略に役立てる

解決方法:ABテストの記録テンプレートを作成し、チーム全体で活用するよう徹底しましょう。 テンプレートには以下の内容を含めると良いです:

分析データ仮説のきっかけとなった分析データ

推測なぜこのデータがこのように見えるのか

あなたの仮説仮説(if-then形式など)

測定する指標測定することにした指標

検査結果考察と今後の行動リストを含む

記録は1ページで完結する簡潔なレポートが理想です。作成後はチーム内、または社内で共有しましょう。

9.テストを繰り返さない

ABテストの結果が仮説を否定した場合、そのまま別のアイデアに移ってしまうのはよくあるパターンです。特に、テストに数週間かけた後は「もう次に行こう」という気持ちになりやすいものです。

どうすればいいのか:

もし、顧客のペインポイントに関するデータに基づいた仮説があり、ABテストでそれが誤りであることが証明された場合、別の選択肢を考えてみてください。例:あなたが特定した問題はまだ存在している。

仮説が成功した場合でも、次の改善案を考えましょう。 例:「商品ページに画像カルーセルを追加したらCVRが改善した」場合、次は「商品動画の追加」など、さらなる高みを目指すABテストに進むこともできます。

なぜ仮説が失敗したのか?ユーザーに聞いてみましょう!

確かなデータに基づいて仮説を立てたとき、ABテストでそれが間違っていることが証明されると、がっかりするかもしれません。しかし、これはより深く掘り下げるための素晴らしい一歩です。 ページ内アンケートを使って、ユーザーの行動を尋ねてみましょう。

例:ルームシェア相手を探すWebサイトで、有料会員登録中に多くのユーザーが離脱していることがデータから判明した場合。仮説として「1ヶ月分の会員料金が必要なことがネックかも」と考え、1週間プランをABテストしたものの、効果なし。ここで思い切って「なぜ登録しなかったのか?」というアンケートを設置すると、多くのユーザーが「プロフィールを作成しないと購入できないのが面倒」と回答。その結果、次のテストは会員登録プロセスの摩擦(フリクション)削減を目的としたものに切り替えることができた。

アイデアを放棄する代わりに、あなたは離脱意図調査を設置しました。アンケートでは、ユーザーに会員権を購入しない理由を尋ねます。その結果、多くのユーザーが、会員権を購入する前にプロフィールを設定しなければならなかったことに腹を立てていると答えました。

もしそうであれば、ABテストの次の反復では、メンバーシップの価格や期間を下げるのではなく、登録プロセスにおける摩擦を減らすことに焦点を当てることができます。

Contentsquareのアンケートは、サイト上でユーザーが特定のアクションを行った場合(例えば、チェックアウトからナビゲートした場合など)に表示されます。

10.結果に基づいて多くの変更を加える

新機能やデザイン変更のアイデアをチームに受け入れさせようとする場合、ABテストの結果は非常に説得力があります。 しかし、データがあると人は安心するため、その実験の示す意味を過大評価してしまうという落とし穴もあります。

例:あなたはメール購読者数の増加を目指しています。 ABテストで「About Usページにサインアップ用ポップアップを追加すると登録数が増える」とわかりました。そこでそのデータに基づいて、すべてのページにポップアップを設置してしまったとします。 結果、もっと登録が増えるかもしれません。 しかし逆に、記事を読みに来たブログ読者が毎回ポップアップに出くわし、直帰率が急上昇するかもしれません。

修正方法:データに基づいて変更を加えるときは、少しずつ・慎重に進めましょう。ABテストはあくまで「1つの狭い問い」に対する答えです。 その結果を、サイト全体への変更に安易に拡大解釈しないことが重要です。

正確なテスト結果が、成功するグロース戦略をつくる

ABテストには時間がかかることもありますが、その結果は売上に直結する改善判断を後押ししてくれます。ただし、ABテストだけがすべてではありません。

ヒートマップ、セッションリプレイ、オンページアンケートなど、デジタル体験インサイトツールは非常に強力です。どのような変更がユーザーのコンバージョンを促したか、仮説のどこが正しく・どこが間違っていたのかを明らかにしてくれます。たとえば、チェックアウトページでセッションリプレイを数件見るだけで、どこに改善すべき要素があるかがすぐに見えてきます。

最も効率的なサイト最適化の方法は、ABテストと体験インサイトの併用です。ABテストの結果に、定性的なユーザー理解を加えることで判断の精度を高め、デジタル体験インサイトから得た気づきに基づいて、より良い仮説を立てて ABテストを行いましょう。このサイクルを回すことで、ユーザー理解に基づいた持続的な成長戦略を実現できます。

ABテストの間違いに関するFAQ

ABテストは、製品に小さな変更を加えることで、コンバージョンを着実に増やすことができる人気の戦略ですが、いくつかの制限があります。

1回の実験で検証できる仮説は1つだけであり、オーディエンスの規模によっては、テストを最大8週間実施する必要があります。ABテストを使ってページの個々の要素を磨き上げようとすれば、数ヶ月から数年にわたるプロジェクトになります。

トラフィックの少ないサイトではうまくいかないかもしれない:あなたのサイトへの訪問者の大きな流れがない限り、ABテストは統計的有意性に到達するのに苦労するだろう。せっかく集めたデータも、偶然の産物になってしまうかもしれません。

大きな変更をテストするには適していない:ABテストは、「これとあれ」という質問にしか答えることができません。小さなコピーやデザインの微調整がコンバージョンを改善できるかどうかを理解するのには役立ちますが、大規模で重要な変更を行うのに役立つほど詳細な結果は得られません。

ABテストの「B」バージョンが最高の結果を出したとしても、その仮説が正しかったと100%断言することはできません。あなたのサイトの修正バージョンが、あなたが考えもしなかった理由でオリジナルを上回る可能性もあるのです。

ABテストと、サイト上での顧客の行動に関する定性的な情報を組み合わせることで、ABテストの限界の多くを克服することができます。

![[Visual] Contentsquare's Content Team](http://images.ctfassets.net/gwbpo1m641r7/3IVEUbRzFIoC9mf5EJ2qHY/f25ccd2131dfd63f5c63b5b92cc4ba20/Copy_of_Copy_of_BLOG-icp-8117438.jpeg?w=1920&q=100&fit=fill&fm=avif)