Per creare un sito web che i clienti possano davvero apprezzare, bisogna capire cosa suscita il loro entusiasmo e cosa invece lo spegne. I test A/B eliminano la necessità di fare congetture durante l'interazione con gli utenti, grazie agli insights concreti che aiutano a identificare e ottimizzare le migliori funzionalità del sito web.

Eseguire regolarmente test A/B ti consente di confrontare le varie supposizioni del team, corroborarle con dati concreti e creare così prodotti migliori per i clienti: insomma... ci guadagnano tutti!

Questa guida esamina le basi dell'A/B testing di siti web e spiega le ragioni per cui tali test sono fondamentali sia per te e la tua azienda, che per le persone che contano davvero: gli utenti. Se vuoi sviluppare, valutare e ottimizzare i test A/B, garantendo che ogni modifica abbia successo, sei nel posto giusto!

Cosa sono i test A/B?

Il test A/B è una metodologia di ricerca che consiste nel confrontare due versioni di un sito web, di un'applicazione, di un prodotto o di una funzionalità per determinare quella in cui si notano le migliori performance. Questi test sono parte integrante del processo di ottimizzazione del tasso di conversione (CRO) e permettono di raccogliere insights sia qualitativi che quantitativi sugli utenti.

Fondamentalmente, un test A/B, anche noto come split test, è un esperimento in cui si mostrano agli utenti due varianti in maniera aleatoria e si adopera l'analisi statistica per determinare quale variante ha le migliori performance in relazione a uno specifico obiettivo di conversione.

Un test A/B, nella sua versione più elementare, serve a confermare o smentire idee e ipotesi. L'esecuzione di questo tipo di test permette di fare domande specifiche sulle modifiche apportate al sito web e di raccogliere dati sull’impatto avuto da tali cambiamenti.

Testando le ipotesi con utenti reali, risparmi un sacco di tempo ed energia che altrimenti avresti dovuto dedicare a iterazioni e ottimizzazioni.

Quello che i test A/B non possono dirti

Un test A/B confronta tra loro le performance di due elementi o varianti. Da solo, Il test A/B mostra solo quale variante raggiunge meglio l'obiettivo, non il motivo per cui questo avviene.

Per esperimenti più efficaci e per apportare modifiche utili al sito web, è fondamentale capire le motivazioni profonde che giustificano il comportamento degli utenti ed evitare soluzioni inadeguata che si basino solo su supposizioni, su colpi di fortuna e sull'opinione degli stakeholder.

Combinare i risultati dei test con gli insights qualitativi, ad esempio quelli ottenuti dalle heatmap, dalle riproduzioni delle sessioni, dai sondaggi e dai strumenti di feedback, offre un approccio in grado di aiutare te e il tuo team a ottimizzare il sito web per una migliore user experience e il raggiungimento degli obiettivi aziendali.

A cosa servono i test A/B?

Il test A/B è una metodologia sistematica impiegata per capire cosa funziona (e cosa no) in qualsiasi elemento di un sito web: una landing page, un logo, una nuova gamma cromatica, l'aggiornamento di una funzionalità, l’intera interfaccia utente (UI) o la messaggistica a proposito del prodotto.

Un programma strutturato per i test, che siano split test per le campagne di marketing e advertising o test A/B per il product management e lo sviluppo di prodotti,rende più efficaci le iniziative di ottimizzazione, individuando le aree problematiche a cui è fondamentale apportare miglioramenti.

Usando questa procedura, il tuo sito web raggiunge il suo obiettivo, quello di generare il massimo dell'engagement e il massimo del fatturato, ma anche tutta un'altra gamma di notevoli vantaggi:

Una migliore user experience: eseguire test A/B evidenzia le funzionalità e gli elementi che hanno maggiore impatto sull'esperienza utente (UX). Tali informazioni permettono al team di sviluppare idee e prendere decisioni sul design, mettendo il cliente è al centro dell'equazione e basandosi su dati concreti.

Maggiorecustomer satisfaction: ottenere insights su cosa gli utenti apprezzano del sito web o del prodotto, permette di offrirgli esattamente quello che vorrebbero. A prescindere dal loro obiettivo durante la navigazione del sito, il test A/B ti aiuta a risolvere i pain point degli utenti e a ridurre la frizione, così da offrire un'esperienza più soddisfacente.

Ottimizzazioni a basso rischio: un test A/B permette di ripartire le risorse in modo da ottenere il massimo rendimento con modifiche minime. Eseguire un test A/B può aiutare a capire se la modifica proposta è gradita dal pubblico di riferimento, aumentando la probabilità di un esito positivo.

Aumento dell'user engagement: i test A/B evitano di basarsi solo su supposizioni ricavate dal CRO, con il coinvolgimento diretto degli utenti nel processo decisionale. Sono questi a scegliere, esprimendo le loro preferenze attraverso azioni, clic e conversioni.

Minore affidamento su supposizioni: i test A/B mettono alla prova le "sensazioni a pelle" e permettono alle aziende di prendere decisioni basate sui dati invece che sull’istinto, che sia per l'oggetto di un’email, per l’architettura dei contenuti di un sito web o la riprogettazione completa del sito web.

Incremento del tasso di conversione: se si capisce qual è l'impatto di determinati elementi dell'user experience sul comportamento degli utenti, il test A/B permette allora di massimizzare il traffico già esistente e aumentare le conversioni.

Ottimizzazione delle performance del sito web: i test A/B permettono di introdurre piccole modifiche progressive, che possono avere un impatto significativo sulla performance del sito web in modo da incrementarne l'affidabilità, ad esempio testando l'API, i microservizi, i cluster e il design dell'architettura.

Validazione del processo decisionale: usando i test A/B è possibile esaminare l'impatto delle nuove funzionalità, il miglioramento delle perfomance o le modifiche al backend, prima che vengano implementate per gli utenti.

Ricorda: il punto di partenza dei test A/B è sempre un'idea o un'ipotesi basata sugli insights degli utenti.

Contentsquare è una piattaforma di experience intelligence, progettata per ottenere dati concreti sui clienti. La piattaforma raccoglie automaticamente i dati comportamentali e le performance del sito web o dell'app, per ricavarne insights su quattro ambiti d'analisi, dandoti così l'opportunità di capire davvero i clienti e il loro user journey.

Ecco i quattro livelli d'analisi che ti permettono di raccogliere insights sugli utenti e capire perché i test A/B vincenti hanno successo, per poi puntare su quello che funziona meglio:

Digital Experience Analytics (DXA): esamina il modo in cui gli utenti interagiscono con il sito web, dai clic ai pattern di navigazione, per migliorare l'user journey.

Digital Experience Monitoring (DEM): monitora costantemente la performance del sito e il comportamento degli utenti per individuare problemi tecnici e migliorare l'user experience.

Product Analytics (PA): monitora e misura le performance dei prodotti digitali, analizzando il modo in cui gli utenti interagiscono con le specifiche funzionalità.

Voice of Customer (VoC): raccoglie il feedback diretto degli utenti attraverso sondaggi e widget per ottenere insights sulla soddisfazione dei clienti e le preferenze degli utenti.

Ecco qualche esempio delle opzioni disponibili sulla piattaforma:

Portare luce sugli user journey e confrontare in parallelo le sessioni di successo e quelle fallimentari.

Analizzare il comportamento sulla pagina e scoprire cosa spinge i clienti a cliccare e cosa invece li lascia indifferenti.

Grazie alla miriade di integrazioni e funzionalità disponibili, Contentsquare ti permette di individuare le aree di frizione più frequenti nell'user experience, suggerisce idee per migliorarle e ti aiuta a capire se le modifiche apportate sono efficaci e per quale motivo lo sono.

Contentsquare ti offre una prospettiva più consapevole su quali sono i prossimi test A/B da eseguire per un maggiore impatto sugli obiettivi di conversione individuati.

Come si esegue un test A/B?

Condurre test A/B è molto più di una semplice modifica dei colori o della posizione dei pulsanti: è un processo che parte dalla valutazione di quello che avviene sul sito web, l'individuazione degli aspetti da migliorare, la verifica delle modifiche e la messa in rilievo degli aspetti che hanno conquistato i clienti.

Con la nostra guida completa su come eseguire i test A/B sul tuo sito web, puoi scoprire tutto sullo sviluppo, la valutazione e l'ottimizzazione dei test A/B. Per cominciare in bellezza, ecco un rapido framework da usare per iniziare subito con i test:

Sviluppo e configurazione dei test A/B

Tutto quello che si ottiene dai test, dalla comprensione approfondita del comportamento degli utenti all'individuazione di opportunità di miglioramento, fa in modo che i test A/B per i siti web siano una procedura in cui gli utenti fanno da protagonisti.

🔍 Alla ricerca di idee

I test A/B si concentrano sulla sperimentazione di teorie, il cui concepimento è il risultato dello studio del mercato e dei clienti. La ricerca quantitativa e qualitativa supporta la preparazione del passaggio successivo: trarre osservazioni utili e generare nuove idee.

Raccogli dati sulle performance del sito web: tutto quanto, dal numero di utenti che visitano il sito ai diversi obiettivi di conversione delle varie pagine, passando per i punteggi di soddisfazione del cliente, per concludere con gli insights sull'UX.

Grazie alle heatmap puoi individuare i punti in cui gli utenti trascorrono più tempo sulle pagine e analizzare il comportamento di navigazione. Gli strumenti di riproduzione delle sessioni sono utili in questa fase, perché raccolgono dati comportamentali sui visitatori, aiutando a individuare eventuali lacune nell'user journey. Questo può inoltre rendere più semplice l’individuazione delle aree problematiche del sito web.

![[Visual] Session Replay | Error Details](http://images.ctfassets.net/gwbpo1m641r7/5DZbkzo3qFEHFqYFZ7eKsE/755984f322cabf5a7554ccbf5c244e6c/Screenshot_2024-11-04_at_21.10.30.png?w=3840&q=100&fit=fill&fm=avif)

Un esempio di riproduzione di una sessione con Contentsquare

💡 Definizione di obiettivi e ipotesi

Prima di effettuare un test A/B, è necessario definire gli obiettivi di conversione: quelle metriche che determinano se la variante riscuote maggior successo rispetto alla versione originale o la baseline di progetto.

Gli obiettivi possono essere di diversa natura, dal cliccare su un pulsante o un link, all'acquistare un prodotto. L'esperimento va preparato scegliendo quali variabili confrontare e come misurarne l'impatto.

Dopo aver individuato un obiettivo, si può passare alla formulazione d'ipotesi che si basino su dati concreti. Queste definiscono quali aspetti della pagina o dell'esperienza utente richiedono un'ottimizzazione e quali modifiche potrebbero avere un impatto sulle performance.

📊 Esecuzione del test

Non dimenticare che all'inizio della procedura di test A/B abbiamo formulato un'ipotesi sugli utenti del sito web. A questo punto si può avviare il test e raccogliere dati statistici per confermare o confutare tale ipotesi.

Basandoti sulla tua ipotesi, crea una variante che potrebbe funzionare dal punto di vista dell'esperienza utente e mettila alla prova con un test A/B, confrontandola alla versione attuale. Usa un software per l'A/B testing per apportare le modifiche desiderate a un elemento del sito web. Tra queste, si includono quelle al colore di un pulsante CTA, la modifica dell'ordine degli elementi nel template della pagina, la rimozione di elementi di navigazione o altri interventi completamente personalizzati.

L'obiettivo è quello di raccogliere dati che mostrino se l'ipotesi del test era corretta, errata o inconcludente. A seconda della dimensione del campione, potrebbe essere necessario aspettare un po' per ottenere un risultato soddisfacente.

Nota importante: uno degli errori più frequenti durante l'esecuzione di test A/B, è quello di non prendere in considerazione la significatività statistica. Se l'esperimento è condotto correttamente, è possibile capire se i risultati sono affidabili e statisticamente significativi. Se non fosse così, sarebbe difficile capire se le modifiche apportate hanno realmente un impatto.

Come generare idee e ipotesi per l'A/B testing

Scopri a che punto i visitatori lasciano il sito: con gli strumenti di analytics tradizionali puoi scoprire dov'è che gli utenti abbandonano il sito e complementare gli insights con quelli ottenuti da uno strumento per i funnel di conversione.

Raccogli il feedback dei clienti: con i sondaggi sulla pagina e il widget di feedback puoi ottenere risposte a testo libero con le opinioni reali degli utenti.

Esegui test di usabilità: gli strumenti per i test di usabilità ti offrono insights sul modo in cui gli utenti reali usano il sito web e ti permettono di ottenere feedback diretto sulle difficoltà incontrate e sulle soluzioni che vorrebbero.

Esamina le riproduzioni delle sessioni: osserva i singoli utenti mentre navigano sul sito, così da capire come si svolge l'esperienza dal loro punto di vista e capire cosa li spinge ad abbandonare.

![[Visual] Exit-Intent- Survey](http://images.ctfassets.net/gwbpo1m641r7/1UqasWRBnczjIUsx8wDIMB/149e80ca4b764400d3295ddb4c9c254b/Feedback_Widget__1_.png?w=1920&q=100&fit=fill&fm=avif)

I sondaggi di Contentsquare ti permettono di interagire direttamente con i tuoi utenti.

Monitoraggio e valutazione dei test A/B

Una volta terminato l'esperimento, è giunto il momento di analizzare i risultati. Il software di test A/B misura i dati di entrambe le versioni e mostra le differenze nelle performance, indicando l'efficacia delle modifiche e se vi sia un miglioramento statisticamente significativo.

Analisi delle metriche e interpretazione dei risultati

I programmi di A/B testing si sviluppano, crescono, si trasformano e raggiungono il successo (o falliscono) attraverso le metriche. Valutando l’impatto delle diverse versioni sulle metriche, puoi assicurarti che ogni modifica al sito permetta all'azienda e ai clienti di raggiungere risultati positivi.

Ecco le metriche di A/B testing da monitorare, per valutare l'impatto degli esperimenti:

Tasso di conversione: il numero di visitatori che effettuano una determinata azione, ad esempio completare un acquisto o compilare un modulo.

Percentuale di clic (CTR): il numero di clic su un link o su una call to action (CTA) diviso per il numero di visualizzazioni dell'elemento.

Tasso di abbandono: la percentuale delle attività sul sito web che il cliente abbandona prima di completarle. Per un sito di e-commerce, questo si traduce nell'abbandono di un articolo nel carrello prima dell’acquisto.

Tasso di fidelizzazione: la percentuale di utenti che tornano sulla stessa pagina o sullo stesso sito web dopo un determinato periodo di tempo.

Frequenza di rimbalzo: la percentuale di visitatori di un sito web che lasciano il sito dopo aver visualizzato soltanto una pagina.

Profondità di scorrimento: la percentuale della pagina visualizzata da un visitatore. Per esempio, se la profondità di scorrimento media è del 50%, significa che, in media, i visitatori del sito web hanno visualizzato la metà del contenuto della pagina.

Tempo di permanenza: la durata media della sessione di un utente prima di lasciare il sito.

Valore medio dell'ordine (AOV): la media dell'importo speso da un cliente per un singolo acquisto.

Customer Satisfaction Score (CSAT): il grado di soddisfazione dei i clienti nei confronti dei prodotti o dei servizi dell'azienda.

Consulta il capitolo completo sulle metriche dei test A/B per assicurarti di raccogliere dati utili per l'analisi dell'esperimento.

Come capire i motivi dietro i risultati dei test A/B

Nei test A/B, le metriche quantitative sono fondamentali per individuare la variante del sito o del prodotto in cui si osservano le migliori performance. Anche i test A/B meglio progettati, però, non sono in grado di individuare con precisione i motivi per cui una variante riscuote più successo di un’altra. Ad esempio, perché una versione di una CTA ottiene risultati migliori dell’altra e come si può replicare lo stesso successo su tutto il sito web?

Le metriche quantitative e qualitative dei test A/B devono lavorare all'unisono: i dati quantitativi rispondono al "cosa" e i dati qualitativi svelano il "perché".

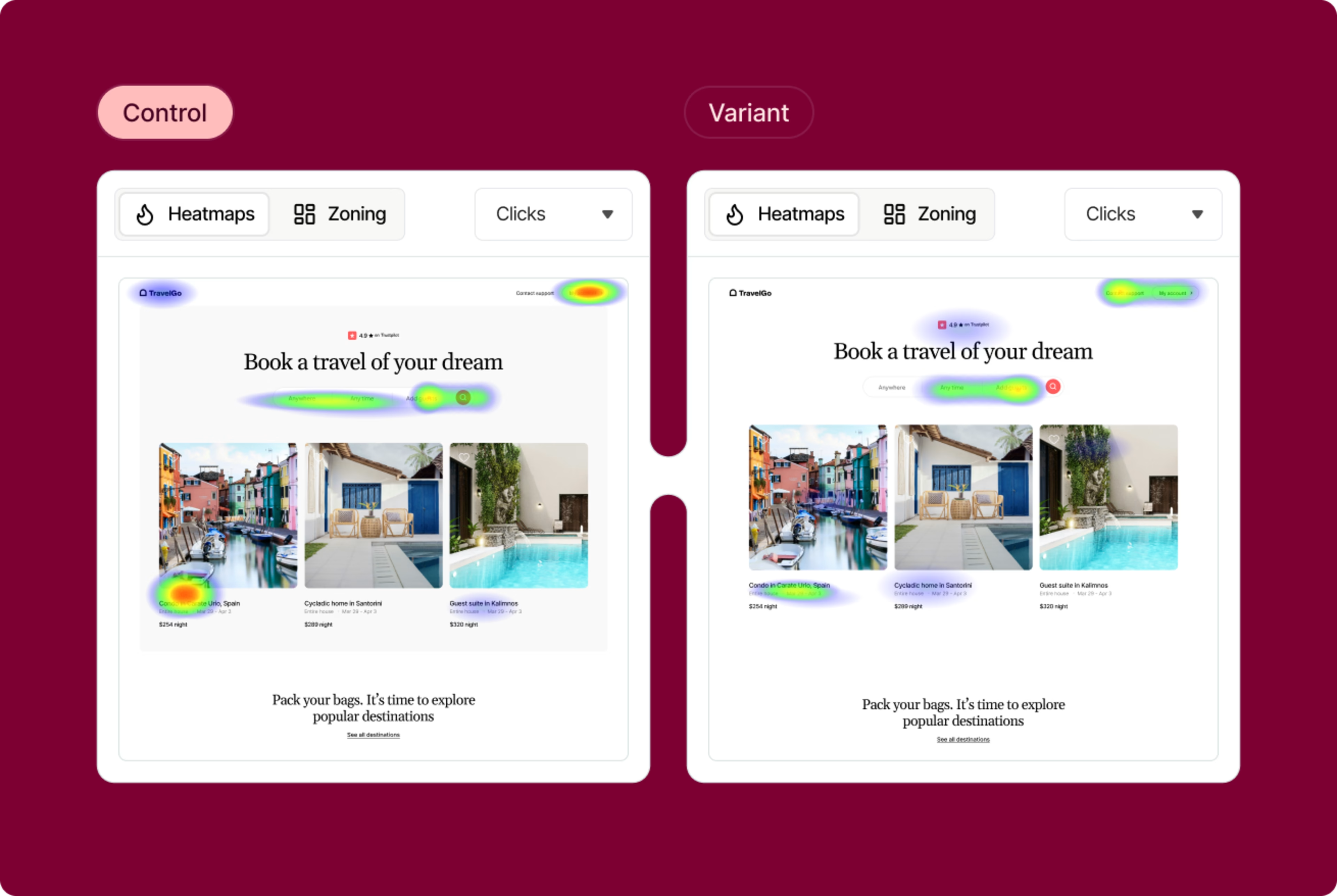

Le funzionalità come le heatmap a zone, Session Replay, Surveys e Feedback Collection di Contentsquare si integrano con i tradizionali strumenti di A/B testing per aiutarti a capire meglio le performance delle diverse varianti.

Durante un test, è possibile monitorare il comportamento degli utenti e raccogliere insights per capire qual è l'impatto di ognuna delle varianti sull'user experience nel sito web. Successivamente, questi strumenti qualitativi possono essere usati per scavare più a fondo nelle teorie, individuare i principali pain point degli utenti o scoprire quali funzionalità del prodotto suscitano maggior interesse:

Le riproduzioni delle sessioni e le heatmap permettono di osservare la reazione dei clienti alle diverse varianti di una specifica pagina, funzionalità o iterazione. Cosa attira l'attenzione dei visitatori e cosa li confonde?

I sondaggi evitano di dover fare congetture quando si tenta di capire il comportamento degli utenti durante i test A/B, permettendo agli utenti di comunicare esattamente quello di cui hanno bisogno e qual è la loro opinione su ciascuna variante.

I widget di feedback ti offrono insights visivi istantanei, provenienti da utenti reali. Gli utenti possono valutare l'esperienza con una delle varianti su una scala, aggiungere contesto, dettagli e fare uno screenshot di un elemento della pagina prima e dopo la modifica.

![[Visual] Feedback-Button rate your experience](http://images.ctfassets.net/gwbpo1m641r7/1jtKOa90vakvficfgrrXTz/81dc0f40dff6d9257d91872c4efed9cb/Feedback_button__1_.png?w=3840&q=100&fit=fill&fm=avif)

Il widget Feedback Collection di Contentsquare: un prodotto Hotjar

Dopo i test A/B

Come per qualsiasi altro processo di ottimizzazione del tasso di conversione (CRO), non si cerca solo la variante del test A/B di maggior successo, ma anche acquisire nozioni concrete da mettere in pratica per migliorare l’esperienza del cliente.

Se la variante risulta vincente, congratulazioni! 🎉 Procedi con l’implementazione, analizza i dati raccolti e trasformali in insights concreti da usare per ottimizzare il sito web. Valuta se puoi sfruttare le nozioni acquisite con l’esperimento e applicarle ad altre pagine del sito, in modo da continuare a iterare e migliorare i risultati statisticamente significativi.

Ricorda anche che i test non conclusivi e quelli "fallimentari" permettono comunque di avere un'idea più chiara di quello che non funziona per gli utenti. Non si perde mai tempo con i test A/B, si può solo imparare qualcosa in più.

Domande frequenti sui test A/B

A/B testing, also known as split URL testing, is the process of running two different versions of the same website in a controlled experiment to see which one resonates with and converts the most users. A/B tests provide valuable insights into user behavior, allowing you to identify which elements impact your conversion rates the most, so you can make changes that drive more people to take a desired action on your product or site.

![[Visual] Contentsquare's Content Team](http://images.ctfassets.net/gwbpo1m641r7/3IVEUbRzFIoC9mf5EJ2qHY/f25ccd2131dfd63f5c63b5b92cc4ba20/Copy_of_Copy_of_BLOG-icp-8117438.jpeg?w=1920&q=100&fit=fill&fm=avif)